原文链接:https://thenewstack.io/using-rustlangs-async-tokio-runtime-for-cpu-bound-tasks/

翻译:trdthg

选题:Akagi201

使用 Tokio 处理 CPU 密集型任务

尽管 async 通常都被应用于异步网络 I/O,但是在这篇文章里,我会像你介绍为什么使用 Tokio 处理 CPU 密集型任务(比如数据分析引擎等)也是一个不错的选择。

Tokio 是什么?

Rust 本身提供了一个类似于 JavaScript 的异步编程模型。

为了充分利用多核和异步 I/O。一个运行时是必须的,尽管社区有很多异步运行时的选择,但是 Tokio 是事实上的标准。尽管 Tokio 在官网上描述到它是 Rust 语言的一个异步运行时,并且提供了编写网络服务所需要的模块,它也可以被用在其它场景。

为什么使用 Tokio 处理 CPU 密集型任务

现代化的数据分析引擎总是不可避免的要处理来自客户端的网络请求,以及通过网络和对象存储系统(比如 ASW S3、GCP Cloud、Azure 等)进行通信。因此,任何使用 Rust 实现的系统,大多都会用 Tokio 去处理这部分网络相关的服务,或者是一部分文件 I/O 服务。

除了应对网络外,数据分析引擎还需要做大量繁重的的 CPU 计算,消耗大量 CPU 资源去进行诸如:重新组织数据存储、提前计算各种索引、或者是直接回复客户端请求等工作。这些复杂计算通常会被切成许多单独的块(我把它们称为 "任务"),然后被并行的处理,以利用到现代 CPU 的多核特性。

任务调度器会决定哪个任务应该在什么时候运行,它会将任务映射到合适的 CPU 内核或者是线程上。

学术界和工业界对于各种任务调度器、工作池、线程池等已经积累了很多年的研究。

我自己已经实现并且使用过几个自定义的任务调度器。他们在大多数时间 (99.9%) 都工作的很好,但是在处理边缘情况(比如快速停机、任务取消、清理等)时,他们的效果非常不尽人意。由于这些任务调度器使用了较低级别的线程原语,出现线程间竞争的情况比比皆是,所以我不建议这样做。

因此,当我在 Rust 生态中寻找一个任务调度器时,你会很自然的选择 Tokio。Tokio 有很多优势:

- 你只需要 Tokio,并不需要添加其他依赖项。

- Tokio 实现了一个复杂的 支持任务窃取的调度器。

- Tokio 内部实现了对 async/await 的支持。并且有许多相对成熟的库去处理流、异步锁、管道、异步取消等。

- Tokio 在 Rust 生态系统中经过了良好测试,并且有着大量使用案例。

- Tokio 通常会将正在运行的任务和

Future放在同一个执行器内,这有利于实现局部缓存。 - Tokio 的 文档 很完善,并且在积极更新维护。

因此,选择 Tokio 作为 CPU 密集型任务的任务调度程序是理所应当的,对吧?WROOOOOOOONG!

使用 Tokio 的反对意见

选择 Tokio 在我们团队中变成了一个热门话题,到现在依然不是所有人都认可这个决定。在我们做 DataFusion 和 InfluxDB IOx 的早期,我们很担心这个问题。以下是一些反对意见:

Tokio 文档的警告:

老版本的 Tokio 文档(比如 1.10 版)里面有一条著名的警告:

If your code is CPU-bound and you wish to limit the number of threads used to run it, you should run it on another thread pool such as Rayon.

如果你的代码要处理 CPU 密集型任务,并且想要尽量减少使用到的线程数,你应该将这些任务分配到另一个线程池比如 Rayon。

这个警告对我们团队和社区都造成了很大的困惑。很多人读了之后都以为 Tokio 永远不应该用来处理 CPU 密集型任务。但是文档的关键其实是说,一个运行时实例(同一个线程池)不应该同时用于 I/O 和 CPU 计算,我们之后澄清了文档 的意图。

顺便说一句,Tokio 文档建议用 Rayon 处理 CPU 密集型任务。Rayon 对于很多程序都是很好的解决方案,但是它并不支持异步。如果你的代码中哪怕只有一点需要使用异步,那你就不得不跨过同步和异步的痛苦边界。我还发现实现一个 基于拉取的执行器模型 会更困难,这种模型要求某个任务必须等待所有的输入都准备好在能在 Rayon 中运行

尾部延迟会拖累你

聪明的人会说:使用 Tokio 处理 CPU 密集型任务会增加请求的尾部延迟,这是难以令人接受的。

尾部延迟?🙄

你可能认为:我正在编写一个数据库,尾部延迟听起来像是对于高负载的 Web 服务器的一个学术问题……”

但其实,这也是需要考虑的:思考一下健康检查,健康检查对于使用容器编排系统(比如 Kubernetes)部署的服务是必不可少的。检查的方式通常是发送一个 HTTP

请求到某个 API,例如 /health。如果该请求已经被分派到某一个任务队列中,但是 Tokio 正在忙于使用 CPU 进行大量数据处理任务,那么

Kubernetes 将不能及时得到“系统正常”的响应,你的进程就会被 K8s 杀死。因此得到结论:由于尾部延迟,你不能将 Tokio 用于 CPU

密集型任务。

但是,就像 Tokio 在文档中阐述的,想要防止你的程序在 CPU 完全饱和的情况下被 K8s

误杀,你应该使用两个独立的线程池。一个用来执行对尾部延迟敏感的任务,就比如响应 /health 接口。另一个用来执行 CPU

密集型任务。这些线程池的的最佳线程数需要根据具体需求去调整。

如果你将 Tokio 运行时只是视为一个复杂点的线程池,那么使用多个运行时实例的想法可能更容易接受,我们将在最后使用专用的执行器演示如何实现这个想法。

单任务开销很高

Tokio 的每个任务开销很高。

对于这点,我一点也不惊讶。人们总是可以实现比 Tokio 运行速度更快的线程池。但是,这些线程池并不是足够稳定,难以应对生产环境的负载,并且他们也不具备像 Tokio 一样的庞大生态系统。

在许多场景下,单任务的开销可以使用“矢量化处理” 来分摊。意思是每个任务回同时处理几千行数据而不是单单一行,你需要将任务分成合理大小的块。你也不能分摊所有工作场景下的开销。但是,对于我们的程序关心的实例来说,Tokio 的任务开销已经微乎其微了

实践

假设你已经被说服了使用 Tokio 去处理 CPU 密集型任务是可行的。现在你应该怎么做?

首先,至关重要的一点是,你的代码应该符合以下原则:异步代码永远不应该花费很长时间才能完成,这一点请参考 Alice Ryhl 的 Async: What is blocking?。这是为了让调度器有机会安排其他事情,比如任务窃取等。

当然了,这个“很长时间”取决于你的程序;Ryhl 建议在优化响应的尾部延迟时,单个异步任务完成时间应该在 10 ~ 100 微秒。我认为在针对 CPU 进行优化时 10~100 毫秒也能有不错的效果。但是在我的测试 estimated per-task Tokio overhead 中,Tokio 单任务的开销在约 10 纳秒范围内,因此几乎不可能用 10 毫秒的任务来测量 Tokio 运行时开销。

其次,将任务分派到一个单独的执行器

专用的执行器

这里是一个简单的例子,演示了我们如何在 InfluxDB IOx 上将任务分配到一个单独的 Tokio 运行时上(完整代码可以在我们的仓库里查看,里面还有关于清理、停机、合并的内容)

pub struct DedicatedExecutor {

state: Arc<Mutex<State>>,

}

/// Runs futures (and any `tasks` that are `tokio::task::spawned` by

/// them) on a separate Tokio Executor

struct State {

/// Channel for requests -- the dedicated executor takes requests

/// from here and runs them.

requests: Option<std::sync::mpsc::Sender<Task>>,

/// Thread which has a different Tokio runtime

/// installed and spawns tasks there

thread: Option<std::thread::JoinHandle<()>>,

}

impl DedicatedExecutor {

/// Creates a new `DedicatedExecutor` with a dedicated Tokio

/// executor that is separate from the threadpool created via

/// `[tokio::main]`.

pub fn new(thread_name: &str, num_threads: usize) -> Self {

let thread_name = thread_name.to_string();

let (tx, rx) = std::sync::mpsc::channel::<Task>();

let thread = std::thread::spawn(move || {

// Create a new Runtime to run tasks

let runtime = Tokio::runtime::Builder::new_multi_thread()

.enable_all()

.thread_name(&thread_name)

.worker_threads(num_threads)

// Lower OS priority of worker threads to prioritize main runtime

.on_thread_start(move || set_current_thread_priority_low())

.build()

.expect("Creating Tokio runtime");

// Pull task requests off the channel and send them to the executor

runtime.block_on(async move {

while let Ok(task) = rx.recv() {

Tokio::task::spawn(async move {

task.run().await;

});

}

let state = State {

requests: Some(tx),

thread: Some(thread),

};

Self {

state: Arc::new(Mutex::new(state)),

}

}

这段代码会在一个新线程 std::thread,并在这个线程里创建了一个新的 Tokio 运行时。运行时会从 channel 获取任务并运行。

注意:这个新的线程很关键,如果你尝试在主线程里或者是任何已经创建过 Tokio 运行时的线程里再次创建新的运行时,程序就会报错,因为已经有一个运行时了。

下面的代码将任务分派到第二个运行时。

impl DedicatedExecutor {

/// Runs the specified Future (and any tasks it spawns) on the

/// `DedicatedExecutor`.

pub fn spawn<T>(&self, task: T) -> Job<T::Output>

where

T: Future + Send + 'static,

T::Output: Send + 'static,

{

let (tx, rx) = tokio::sync::oneshot::channel();

let fut = Box::pin(async move {

let task_output = task.await;

tx.send(task_output).ok()

});

let mut state = self.state.lock();

let task = Task {

fut,

};

if let Some(requests) = &mut state.requests {

// would fail if someone has started shutdown

requests.send(task).ok();

} else {

warn!("tried to schedule task on an executor that was shutdown");

}

Job { rx, cancel }

}

}

上面的代码使用了一个名为 Job 的结构体,它是一个对 Future 的简单包装,Job 能够将 Future 的执行结果从单独的执行器内传输回主线程。相关代码如下。

#[pin_project(PinnedDrop)]

pub struct Job<T> {

#[pin]

rx: Receiver<T>,

}

impl<T> Future for Job<T> {

type Output = Result<T, Error>;

fn poll(

self: Pin<&mut Self>,

cx: &mut std::task::Context<'_>,

) -> std::task::Poll<Self::Output> {

let this = self.project();

this.rx.poll(cx)

}

}

就是这样!你可以在 Github gist 中找到所有代码。

原文链接:https://lucumr.pocoo.org/2021/11/14/abusing-serde/

翻译:trdthg

选题:trdthg

Rust 冒险:滥用 Serde

当你让一个 Rust 程序员指出自己最喜欢的东西时,他们会很快的指出 serde 是一个让工作愉快好帮手。serde 是一个 Rust 的序列化和反序列化框架。它的格式相对独立,可以让你处理 JSON,YAML 以及一系列不同的格式。

除了上面的之外,还有很多东西可以用 serve 完成。我认为有一些用例相当有趣,值得分享。

滥用序列化

Abusing Serialization

其中一个有趣的用例是用 serde 作为某种形式的反射框架,将结构体暴露给其他的不能原生支持 Rust 结构体的环境。在这些情况下,作为一个开发者,你序列化了一个可以被序列化的对象,接着立即以某种稍微不同的格式再次反序列化它。相比于反序列化,我们也可以自定义一个序列化器用来 '捕获' 序列化的调用。这是在 IPC,模板引擎上下文、格式转换中常用的模式。

这在实践中大概是什么样呢?让我们从用户的角度看一下我写的 MiniJinja 模板引擎。MiniJinja 使用 serde 作为核心数据模型,将结构化的数据传递给模板,以便它们可以在运行时进行评估。下面是一些给开发者的示例代码:

#[derive(Serialize, Debug)]

pub struct User {

name: String,

}

fn main() {

let mut env = Environment::new();

env.add_template("hello.txt", "Hello {{ user.name }}!")

.unwrap();

let template = env.get_template("hello.txt").unwrap();

let user = User {

name: "John".into(),

};

println!("{}", template.render(context!(user)).unwrap());

}

如你所见,我们定义了一个叫 User 的结构体,可以使用默认的 Serialize 实现将它序列化。这个对象接着被传递到

context!()。context!() 所做的就是创建了一个 map,然后将一个键设为

user,接着设置为该变量的值。这样做的目的是允许模板引擎访问到 user 的 '属性',例如 name。Rust

不是动态语言,这意味着通常在运行时做这样的事情是不可能的。但是由于 serde 为 User 实现了

Seralize,我们可以这样做。具体的实现大致如下(伪代码):

impl Serialize for User {

fn serialize(&self, serializer: S) -> Result<S::Ok, S::Error>

where S: Serializer

{

let s = serializer.serialize_struct("User", 1);

s.serialize_field("name", &self.name)?;

s.end()

}

}

正常情况下,serializer 是一个类似于 JSON 序列化器的东西,它可以将结构体写入到一个字符串或者是文件,在这个过程中把它编码为 JSON。但是 serde 提供的接口并不要求用户必须这样。实际上,MiniJinja 直接将结构体编码为一个内存中的结构,模板引擎可以解析它。

这种模式并不新颖,serde 本身其实也有使用。当你使用 serde 的 flatter 功能时,serde 会启用一个内部缓冲模式,数据会被存储在一个内部的 Context 类型中,Context 类型可以表示 serde 数据模型的全部内容。然后这个 context 可以被传递给另一个序列化器中。

我不仅在 MiniJinja,同时也在 insta (一个快照测试工具)使用到这种模式。为了避免由于非确定性数据导致的测试快照的不稳定性,我首先将其序列化为一种内部的格式,接着在该格式上进行一个再加工,最后再将其序列化为最终的格式(例如 YAML)。

TLS 恶作剧

TLS Shenanigans

TLS:Thread Local Storage,Shenanigans:恶作剧

然而,MiniJinja 在此处使用 serde 的有趣之处在于,它允许在序列化和序列化器之间传递不兼容的数据。如前所述,serde 有一个特定的数据模型,不符合该数据模型的东西都会遇到这个问题。例如,serde 可以编码的最大整型是 i128。如果你需要一个任意精度的整型,那就不走运了。但是还是有办法的,你可以使用 带内信令(in-band signalling)传递额外数据。例如,serde JSON 序列化器能够表示任意精度整型,因为它在单值对象中保留了一个特殊的键,并用它去指示 JSON 序列化 / 反序列化器组合,决定这个任意精度的整型是否要被序列化。它看起来像这样:

{ "$serde_json::private::Number": "value" }

但是你应该能发现,如果一个人给出了这样的 JSON 文档,serde JSON 会把它当作任意精度的整形去解析,这意味着 'value' 部分本身也需要于 serde 兼容。对于任意精度的整型,这没有问题,因为它可以用字符串表示。但是假如你想在序列化和反序列化中传递的东西根本不能序列化呢?

这时,巧妙地利用 thread local 就是一种变通方法。

在 MiniJinja 中,运行时值的内部表示是一个叫做 Value

的结构体。正如你所期望的,它可以容纳整型,浮点数,字符串,列表,对象等等。然而,他也可以容纳一些 serde

完全无法解析的类型。特别是它可以保存一种特殊类型的字符串,称为 'safe' string, 它是一个存储了安全的 HTML

代码的字符串,不需要转义,也不需要所谓的 '动态值'。后者特别有趣,因为它不能被序列化。

什么是动态值?它实际上是具有状态的对象的句柄,应该直接传递给模板。这里的一个例子是 MiniJinja 中的 loop 变量:

<ul>

{% for item in seq %}

<li>{{ loop.index }}: {{ item }}</li>

{% endfor %}

</ul>

MiniJinja(类似于 Jinja2)提供了一个特殊的 loop 变量可以访问循环的状态。例如,你可以通过 loop.index

来获取当前循环的迭代次数。在 MiniJinja 的工作原理中,'循环控制器' 本身会被直接传递给模板,并且把值本身当作引用计数存进去。

pub struct LoopState {

len: AtomicUsize,

idx: AtomicUsize,

}

let controller = Rc::new(LoopState {

idx: AtomicUsize::new(!0usize),

len: AtomicUsize::new(len),

});

当循环迭代时,控制器上的索引会 +1。

controller.idx.fetch_add(1, Ordering::Relaxed);

控制器本身会被直接添加到上下文中:

let template_side_controller = Value::from_object(controller);

为了达到这个目的,控制器需要实现 MiniJinja 内部的 Object 特征,下面是一个最小实现:

impl Object for LoopState {

fn attributes(&self) -> &[&str] {

&["index", "length"][..]

}

fn get_attr(&self, name: &str) -> Option<Value> {

let idx = self.idx.load(Ordering::Relaxed) as u64;

let len = self.len.load(Ordering::Relaxed) as u64;

match name {

"index" => Some(Value::from(idx + 1)),

"length" => Some(Value::from(len)),

_ => None,

}

}

}

在模板引擎那一边,系统知道当 index 属性被使用时,需要调用 get_attr() 方法。

到目前为止我们所说的都是理论,serde 究竟是如何做的呢?当 Value::from_object 调用时,传入的值会被 move 到 value

对象里。这样做不需要特殊处理,特别是由于已经使用了引用计数。但是现在的问题是,对于像 LoopState 这样本身没有实现 Serialize

的东西,它的值是如何被序列化的?答案是线程本地存储(thread local storage)和一个合作的(co-operating)序列化和反序列化器。

越过边界的 State

Out of Bound State

隐藏在 MiniJinja 的 Value 实现有这样一段代码:

const VALUE_HANDLE_MARKER: &str = "\x01__minijinja_ValueHandle";

thread_local! {

static INTERNAL_SERIALIZATION: AtomicBool = AtomicBool::new(false);

static LAST_VALUE_HANDLE: AtomicUsize = AtomicUsize::new(0);

static VALUE_HANDLES: RefCell<BTreeMap<usize, Value>> = RefCell::new(BTreeMap::new());

}

fn in_internal_serialization() -> bool {

INTERNAL_SERIALIZATION.with(|flag| flag.load(atomic::Ordering::Relaxed))

}

它们的用处是,Value 自身能够感知到什么时候使用内部序列化的特殊形式。这种内部序列化是一种特殊形式的序列化,我们明确知道我们的序列化数据的接收者是一个可以理解该数据的反序列化器。我们没有直接对数据进行序列化,而是将其存入到 TLS 中,然后把数据的句柄序列化到 serde 序列化器中。反序列化器会先反序列化句柄,接着再从 TLS 中提取值。

因此,我们的循环控制器序列化的实现大致如下:

impl Serialize for Value {

fn serialize<S>(&self, serializer: S) -> Result<S::Ok, S::Error>

where

S: Serializer,

{

// enable round tripping of values

if in_internal_serialization() {

use serde::ser::SerializeStruct;

let handle = LAST_VALUE_HANDLE.with(|x| x.fetch_add(1, atomic::Ordering::Relaxed));

VALUE_HANDLES.with(|handles| handles.borrow_mut().insert(handle, self.clone()));

let mut s = serializer.serialize_struct(VALUE_HANDLE_MARKER, 1)?;

s.serialize_field("handle", &handle)?;

return s.end();

}

// ... here follows implementation for serializing to JSON etc.

}

}

如果它被序列化为 JSON,我们大致能看到这样的东西:

{ "\u0001__minijinja_ValueHandle": 1 }

而真正的循环控制器将被存储在 VALUE_HANDLES 中句柄为 1 处。现在我们如何从里面的到数值呢?在 MiniJinja

中,反序列化其实从未发生,只有序列化。而且序列化也只是将内存中的对象组装起来。因此,我们只需要让序列化器理解带内信令如何处理,并以此找到带外的值。

impl ser::SerializeStruct for SerializeStruct {

type Ok = Value;

type Error = Error;

fn serialize_field<T: ?Sized>(&mut self, key: &'static str, value: &T) -> Result<(), Error>

where

T: Serialize,

{

let value = value.serialize(ValueSerializer)?;

self.fields.insert(key, value);

Ok(())

}

fn end(self) -> Result<Value, Error> {

match self.name {

VALUE_HANDLE_MARKER => {

let handle_id = self.fields["handle"].as_usize();

Ok(VALUE_HANDLES.with(|handles| {

let mut handles = handles.borrow_mut();

handles

.remove(&handle_id)

.expect("value handle not in registry")

}))

}

_ => /* regular struct code */

}

}

}

Ser-to-De

上面的例子是你可以滥用的一种方式,但是同样的模式在真实的序列化和反序列化中也可以用到。在 MiniJinja 中,我可以不使用序列化,因为我有效地利用了序列化代码,从一种内存格式转换到另一种内存格式。如果你想在进程间传递数据,情况就会变得棘手一些,实际的序列化就是必要的。例如,你想建立一个 IPC 系统,在进程之间交换数据,这里的挑战是,出于性能的考虑,对于比较大的内存段,你必须使用共享内存,或者是以文件描述符的形式传递打开的文件(因为这些文件有可能是 socket)。在我的实验性 unix-ipc crate 中,我就是这样做的。

我在这里建立了一个二级缓冲区,它可以放置文件描述符。同样,这里必须使用 TLS。

API 大致如下:

pub fn serialize<S: Serialize>(s: S) -> io::Result<(Vec<u8>, Vec<RawFd>)> {

let mut fds = Vec::new();

let mut out = Vec::new();

enter_ipc_mode(|| bincode::serialize_into(&mut out, &s), &mut fds)

.map_err(bincode_to_io_error)?;

Ok((out, fds))

}

从用户的角度来看,这些都是透明的。当一个 Serailize 实现遇到了一个文件对象时,它可以检查是否应该使用 IPC 的序列化,如果是,它可以把 FD

存起来,enter_ipc_mode 基本上将 fds 绑定到了一个线程局部变量里,接着调用 register_fd

注册它。例如,下面展示了内部句柄的序列化方式:

impl<F: IntoRawFd> Serialize for Handle<F> {

fn serialize<S>(&self, serializer: S) -> Result<S::Ok, S::Error>

where

S: ser::Serializer,

{

if is_ipc_mode() {

// effectively a weird version of `into_raw_fd` that does

// consume

let fd = self.extract_raw_fd();

let idx = register_fd(fd);

idx.serialize(serializer)

} else {

Err(ser::Error::custom("can only serialize in ipc mode"))

}

}

}

然后是反序列化:

impl<'de, F: FromRawFd + IntoRawFd> Deserialize<'de> for Handle<F> {

fn deserialize<D>(deserializer: D) -> Result<Handle<F>, D::Error>

where

D: de::Deserializer<'de>,

{

if is_ipc_mode() {

let idx = u32::deserialize(deserializer)?;

let fd = lookup_fd(idx).ok_or_else(|| de::Error::custom("fd not found in mapping"))?;

unsafe { Ok(Handle(Mutex::new(Some(FromRawFd::from_raw_fd(fd))))) }

} else {

Err(de::Error::custom("can only deserialize in ipc mode"))

}

}

}

从用户的角度来看,他只需要通过 IPC channel 传递一个 Handle::new(my_file) 就能实现。

Serde 的现状

State of Serde

不幸的是,上面所有的东西都依赖线程本地变量和对内信令。整体上都不是很好,如果有一天出了 serde 2.0,我希望有更好的方法实现上面的内容。

实际上,现在的 serde 仍然有不少问题和上述的 Hack 行为相关。

- serde requires in-band signalling

- Internal buffering disrupts format-specific deserialization features

- serde_json's arbitrary precision feature incompatible with flatten

说到这里,在我们需要重写 serde 之前,肯定还有进一步可以被滥用的地方。但是现在是时候应该慢慢考虑 serve 未来版本的设想了它应该对数据模型的支持更友好,可以用更少的 Hack 来脱离规定框架。

原文链接:https://lucumr.pocoo.org/2022/1/6/rust-extension-map/

翻译:trdthg

选题:trdthg

拓展 Rust 中的 Map

在 Rust 中,如果你想为用户提供一个灵活的 API,一般可以引入泛型参数。以一个 web 框架为例,它可能需要一个程序类型,并且需要传递给很多函数。这个程序类型需要能够以配置的形式被参数化。

引入 Any 特征

一个解决方法是使用 Any 特征。它需要一个 'static 的生命周期,当你之后使用它时,还需要用 Box

进行装箱。比如我们可能对它进行向下转型,即转换为原始的类型。这意味着你可以在某个地方(比如我们的 App)中存储和获取任意类型。

我们期望的 API 大致如下:

let app = App::new();

// place in extension map

app.extensions().insert(Config { ... });

app.extensions().insert(Database { ... });

// retrieve from extension map

let config = app.extensions().get::<Config>();

我们的 app 需要容纳其他拓展的类型,以便之后使用。

现在,让我们试试最简单的实现方式:准备一个 Extensions 对象,让它实现插入和获取的方法。如果一个拓展还不存在,我们就自动插入一个默认的(需要实现

Default 特征)。

use std::collections::HashMap;

use std::any::{Any, TypeId};

#[derive(Default)]

pub struct Extensions {

map: HashMap<TypeId, Box<dyn Any>>,

}

impl Extensions {

pub fn insert<T: 'static>(&mut self, value: T) {

self.map.insert(TypeId::of::<T>(), Box::new(value));

}

pub fn get<T: 'static>(&self) -> &T {

self.map.get(&TypeId::of::<T>())

.and_then(|b| b.downcast_ref())

.unwrap()

}

pub fn get_mut<T: Default + 'static>(&mut self) -> &mut T {

self.ensure::<T>();

self.map.get_mut(&TypeId::of::<T>())

.and_then(|b| b.downcast_mut())

.unwrap()

}

fn ensure<T: Default + 'static>(&mut self) {

if self.map.get(&TypeId::of::<T>()).is_none() {

self.insert(T::default());

}

}

}

上面的代码非常直接,但是存在两个问题:首先,只有 get_mut 能够调用 ensure 去插入默认值,如果有人直接调用 get 就会导致

panic。第二个问题是,借用检查器会让之后的编写非常困难。上面的 map 对于解决经典的问题(例如 app)是很有用的,你只需要配置一次,自那之后 map

就像是被冻结了一样,因为有太多的引用在飞来分飞去,以至于没有人能够得到 &mut 的引用。

how does it work?

上面的代码是如何做到的呢,Rust 中的每一种类型都会有一个 type ID,你可以使用 TypeId::of::<T>()

获取。他是唯一的,你可以用它进行比较,或者是作为 map 的键来使用。每种类型只允许有一个值。接着我们把 T 作为 dyn Any 存储在 map

里,Any 特征允许我们使用 downcast_ref 和 downcast_mut 方法拿到原始类型。由于我们使用了 ensure

方法确保这里的类型存在,因此可以安全的 unwrap。

内部可变性

让我们看一个 web 框架或者是模板引擎的常见案例。以

MiniJinja(模板引擎)为例,它里面有一个 State

对象,每次模板初始化时都会创建一次,State 没有实现 Send 和 Sync,MiniJinja 在评估时需要 State。如果你想让用户能够放入自定义的

State 呢?在这种情况下,我们可以通过在内部使用 RefCell 来调整上面的类型。

use std::collections::HashMap;

use std::any::{Any, TypeId};

use std::cell::{Ref, RefCell, RefMut};

#[derive(Default)]

pub struct Extensions {

map: RefCell<HashMap<TypeId, Box<dyn Any>>>,

}

impl Extensions {

pub fn insert<T: 'static>(&self, value: T) {

self.map.borrow_mut().insert(TypeId::of::<T>(), Box::new(value));

}

pub fn get<T: Default + 'static>(&self) -> Ref<'_, T> {

self.ensure::<T>();

Ref::map(self.map.borrow(), |m| {

m.get(&TypeId::of::<T>())

.and_then(|b| b.downcast_ref())

.unwrap()

})

}

pub fn get_mut<T: Default + 'static>(&self) -> RefMut<'_, T> {

self.ensure::<T>();

RefMut::map(self.map.borrow_mut(), |m| {

m.get_mut(&TypeId::of::<T>())

.and_then(|b| b.downcast_mut())

.unwrap()

})

}

fn ensure<T: Default + 'static>(&self) {

if self.map.borrow().get(&TypeId::of::<T>()).is_none() {

self.insert(T::default());

}

}

}

从用户的角度来看,几乎没有变化。主要的区别是你不需要一个可变引用就能调用 get_mut,这一壮举是由 RefCell 实现的,Refcell

能够将检查移动到运行时。当一个 RefMut 被给出时,如果已经存在任何的可变或不可变引用,就会发生

panic。对于这里的用户来说,这并不是一个很大的问题,因为我们可以很容易地确保只有一个可变的引用在使用。特别棒的是,Ref 和 RefMut

类型提供了一个静态的 map 方法,让你可以轻松派生出另一个 Ref 或 RefMut,并保持原来的引用,但对值进行转换。

同步支持

如果我们想要用 Send 和 Sync 来实现和上面相同的效果呢?我们需要一个锁。可惜的是标准库提供的 Mutex 和 RwLock 不能让你在拿到锁的同时

map,你可以使用 parking_lot 替代,它实现了必要的一些方法。

use parking_lot::{

MappedRwLockReadGuard,

MappedRwLockWriteGuard,

RwLock,

RwLockReadGuard,

RwLockWriteGuard,

};

use std::any::{Any, TypeId};

use std::collections::HashMap;

#[derive(Default)]

pub struct Extensions {

map: RwLock<HashMap<TypeId, Box<dyn Any>>>,

}

impl Extensions {

pub fn insert<T: Send + Sync + 'static>(&self, value: T) {

self.map.write().insert(TypeId::of::<T>(), Box::new(value));

}

pub fn get<T: Send + Sync + Default + 'static>(&self) -> MappedRwLockReadGuard<'_, T> {

self.ensure::<T>();

RwLockReadGuard::map(self.map.read(), |m| {

m.get(&TypeId::of::<T>())

.and_then(|b| b.downcast_ref())

.unwrap()

})

}

pub fn get_mut<T: Send + Sync + Default + 'static>(&self) -> MappedRwLockWriteGuard<'_, T> {

self.ensure::<T>();

RwLockWriteGuard::map(self.map.write(), |m| {

m.get_mut(&TypeId::of::<T>())

.and_then(|b| b.downcast_mut())

.unwrap()

})

}

fn ensure<T: Default + Send + Sync + 'static>(&self) {

if self.map.read().get(&TypeId::of::<T>()).is_none() {

self.insert(T::default());

}

}

}

注意:由于 Any 并没有实现 Debug,所以我们很难为我们的 map 实现 Debug 特征,一些简单的改变并不能解决目前的问题。下半部分我们将介绍

as-any 模式

我们面临的挑战是,在 Rust 里,你不能使用 Box<Any + Debug>,然而还是有一些方法解决这个问题。

为 map 实现 Debug

简化问题

我们的目标是对 Box<dyn Any> 做一个包装,并让 Wrapper 实现 Debug。

#[derive(Debug)]

struct AnyBox(Box<dyn Any + Debug>);

如果你尝试编译,编译器应该会很不高兴的抛出错误:

error[E0225]: only auto traits can be used as additional traits in a trait object

--> src/main.rs:9:29

|

9 | struct AnyBox(Box<dyn Any + Debug>);

| --- ^^^^^ additional non-auto trait

| |

| first non-auto trait

|

= help: consider creating a new trait with all of these as supertraits and

using that trait here instead: `trait NewTrait: Any + Debug {}`

超级特征

幸运的是,编译器再次为我们指明了解决之道,我们需要创建一个父特征,并利用特征约束。同时,我们为所有实现了 Any 和 Debug 的类型实现我们的超级特征。就像下面这样:

#[derive(Debug)]

struct AnyBox(Box<dyn DebugAny>);

trait DebugAny: Any + Debug {}

impl<T: Any + Debug + 'static> DebugAny for T {}

你可以想这样构建一个 Box,但是真正不能通过编译的是向下转型

fn main() {

let any_box = AnyBox(Box::new(42i32));

dbg!(any_box.0.downcast_ref::<i32>());

}

编译器会告诉我们,AnyBox 中的值并没有 downcast_ref 方法

error[E0599]: no method named `downcast_ref` found for struct

`Box<(dyn DebugAny + 'static)>` in the current scope

--> src/main.rs:15:20

|

15 | dbg!(any_box.0.downcast_ref::<i32>());

| ^^^^^^^^^^^^ method not found in `Box<(dyn DebugAny + 'static)>`

原因是 Box<dyn DebugAny> 并不是 Box<dyn Any>,因此我们不能那里得到 Any

特征拥有的方法。那么我们如何解决这个问题呢?最简单的方法是 "as any" 模式,我们在我们的 DebugAny

特征上实现一个方法,将其向上转换为一个 Any。看起来像这样:

trait DebugAny: Any + Debug {

fn as_any(&self) -> &dyn Any;

fn as_any_mut(&mut self) -> &mut dyn Any;

}

impl<T: Any + Debug + 'static> DebugAny for T {

fn as_any(&self) -> &dyn Any { self }

fn as_any_mut(&mut self) -> &mut dyn Any { self }

}

现在虽然我们依然不能在 DebugAny 上调用 downcast_ref,但是我们可以拿走它的值,并调用 as_any 得到一个

&dyn Any:

fn main() {

let any_box = AnyBox(Box::new(42i32));

dbg!(any_box.0.as_any().downcast_ref::<i32>());

dbg!(&any_box);

}

但是当我们运行后,却得到了一个 None。发生什么事了???

[src/main.rs:23] any_box.0.as_any().downcast_ref::<i32>() = None

这个谜题的答案与方法解析的工作方式和空白实现有关。当我们在 Box<dyn DebugAny> 上调用 as_any 时,Box

并没有发生自动解引用,事实上调用的是 Box<dyn DebugAny> 的 as_any,因为 Box 现在也实现了我们的

DebugAny。那么,我们如何穿过这个 Box 呢?通过手动解引用。

fn main() {

let any_box = AnyBox(Box::new(42i32));

dbg!((*any_box.0).as_any().downcast_ref::<i32>());

dbg!(&any_box);

}

这样就是我们预期的值了

[src/main.rs:23] (*any_box.0).as_any().downcast_ref::<i32>() = Some(

42,

)

[src/main.rs:24] &any_box = AnyBox(

42,

)

可调试的 Extension Map

有了上面的经验,我们现在可以拿出之前的非同步 map,稍加改造就能为其实现 Debug。

use std::any::{Any, TypeId};

use std::cell::{Ref, RefCell, RefMut};

use std::collections::HashMap;

use std::fmt::Debug;

trait DebugAny: Any + Debug {

fn as_any(&self) -> &dyn Any;

fn as_any_mut(&mut self) -> &mut dyn Any;

}

impl<T: Any + Debug + 'static> DebugAny for T {

fn as_any(&self) -> &dyn Any { self }

fn as_any_mut(&mut self) -> &mut dyn Any { self }

}

#[derive(Default, Debug)]

pub struct Extensions {

map: RefCell<HashMap<TypeId, Box<dyn DebugAny>>>,

}

impl Extensions {

pub fn insert<T: Debug + 'static>(&self, value: T) {

self.map

.borrow_mut()

.insert(TypeId::of::<T>(), Box::new(value));

}

pub fn get<T: Default + Debug + 'static>(&self) -> Ref<'_, T> {

self.ensure::<T>();

Ref::map(self.map.borrow(), |m| {

m.get(&TypeId::of::<T>())

.and_then(|b| (**b).as_any().downcast_ref())

.unwrap()

})

}

pub fn get_mut<T: Default + Debug + 'static>(&self) -> RefMut<'_, T> {

self.ensure::<T>();

RefMut::map(self.map.borrow_mut(), |m| {

m.get_mut(&TypeId::of::<T>())

.and_then(|b| (**b).as_any_mut().downcast_mut())

.unwrap()

})

}

fn ensure<T: Default + Debug + 'static>(&self) {

if self.map.borrow().get(&TypeId::of::<T>()).is_none() {

self.insert(T::default());

}

}

}

向 map 里面添加点东西,打印一下:

[src/main.rs:63] &extensions = Extensions {

map: RefCell {

value: {

TypeId {

t: 13431306602944299956,

}: 42,

},

},

}

在这个例子中,我在 map 中放置了一个 32 位的整数 42,它打印出了作为键的 TypeId,和作为值的 42。

保留类型名称

如果你想保留原来的类型名称,而不仅仅是类型的 ID,我们可以使用一个自定义的类型作为 map 的键。通过对 TypeId 和 TypeName 做一次简单的包装就能轻松实现:

use std::any::{TypeId, type_name};

use std::hash::{Hash, Hasher};

use std::fmt::{self, Debug};

pub struct TypeKey(TypeId, &'static str);

impl TypeKey {

pub fn of<T: 'static>() -> TypeKey {

TypeKey(TypeId::of::<T>(), type_name::<T>())

}

}

impl Hash for TypeKey {

fn hash<H: Hasher>(&self, state: &mut H) {

self.0.hash(state);

}

}

impl PartialEq for TypeKey {

fn eq(&self, other: &Self) -> bool {

self.0 == other.0

}

}

impl Eq for TypeKey {}

impl Debug for TypeKey {

fn fmt(&self, f: &mut fmt::Formatter<'_>) -> fmt::Result {

write!(f, "{}", self.1)

}

}

接着用它替换掉原来的键,调试一下:

[src/main.rs:90] &extensions = Extensions {

map: RefCell {

value: {

i32: 42,

alloc::vec::Vec<i32>: [

1,

2,

3,

],

},

},

}

注意,我在 map 中额外插入了一个 Vec<i32>,以获得更明显的输出。

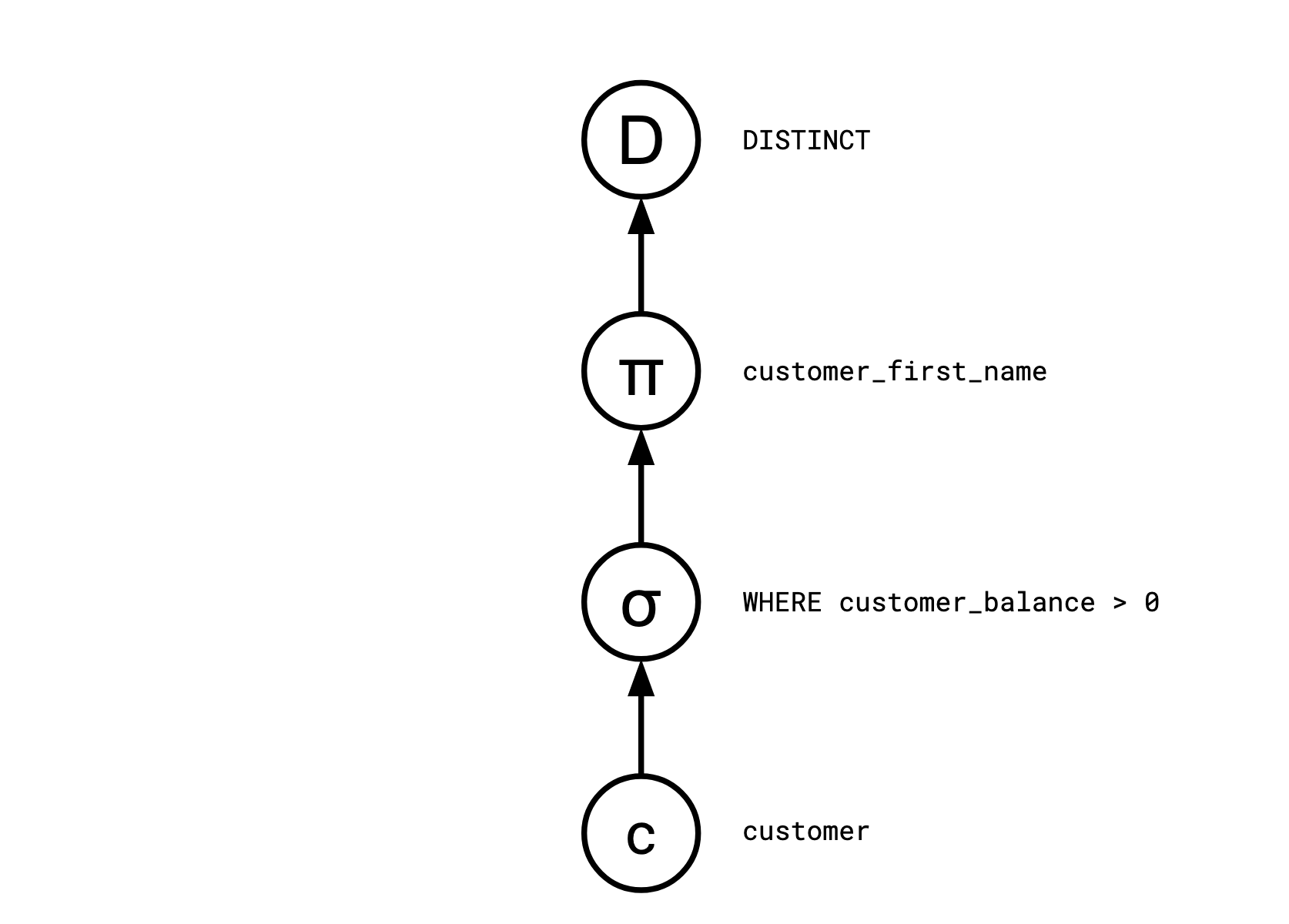

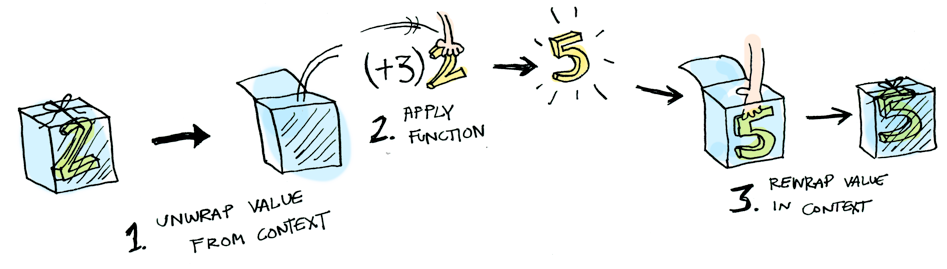

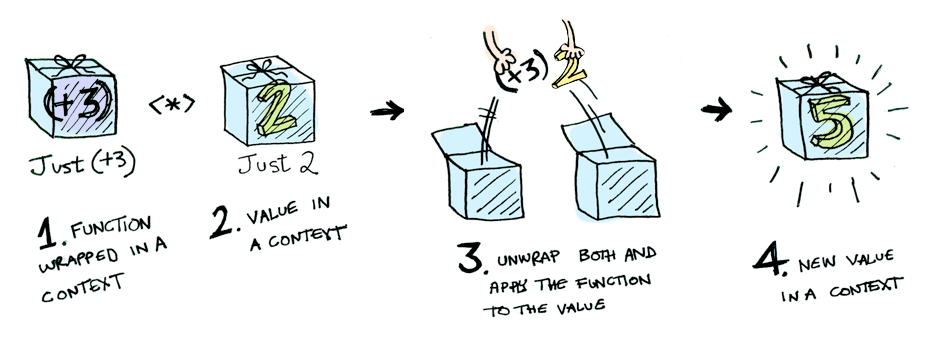

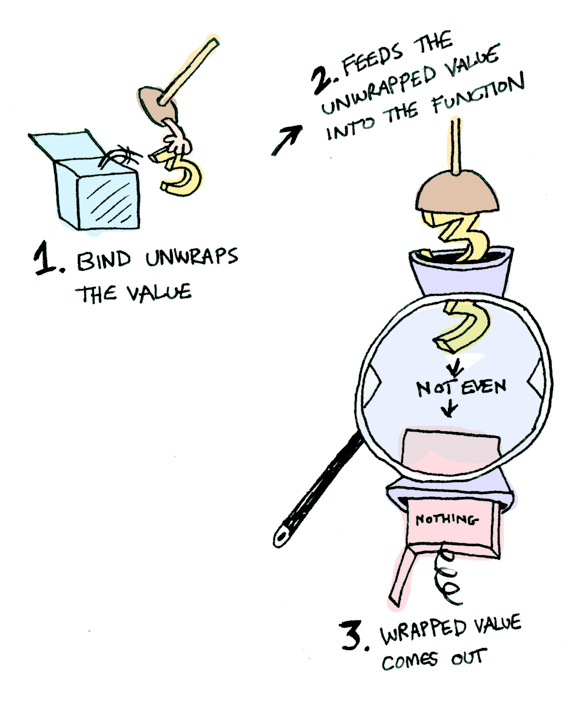

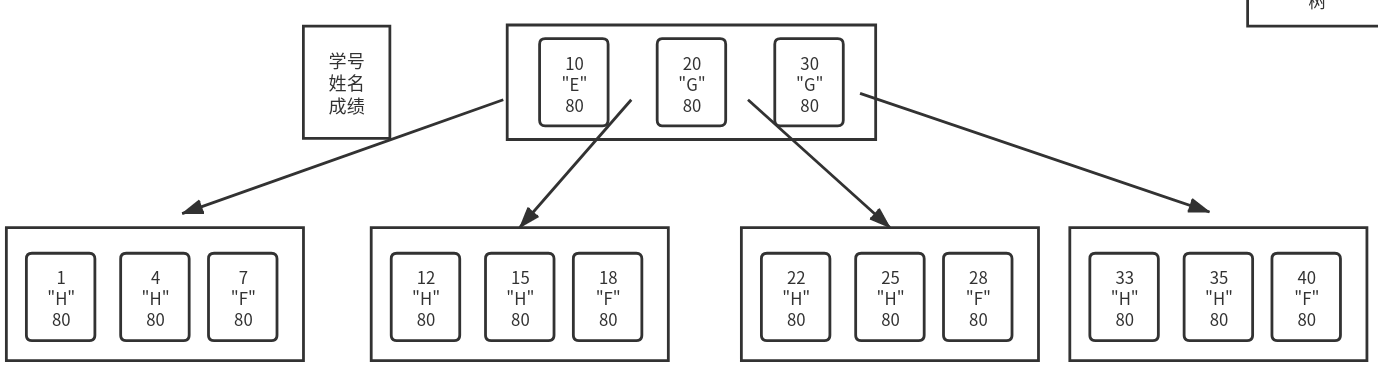

查询引擎:推送与拉取

考虑以下的 SQL 语句

SELECT DISTINCT customer_first_name

FROM customer

WHERE customer_balance > 0

查询优化器通常将这样的 SQL 查询编译成一系列离散运算符:

Distinct

<- Map(customer_first_name)

<- Select(customer_balance > 0)

<- customer

在基于 Pull 的系统中,消费者 customers 驱动系统。每个运算符运算后都会产生一个新行:用户将向根节点(Distinct)请求一行,这一行回向

Map 询问一行,接着向 Select 询问一行,依此类推。

在基于 Push 的系统中,生产者 producers 驱动系统。每个运算符,当他接收到数据时,就会告知下游的运算符,customer

作为查询基表回告诉 Select 自己的信息,接着是 Map、Distinct。

Pull-Based 查询引擎

基于拉取的查询引擎一般也被称为使用 Volcano 或 Iterator 模型。这是最古老和最著名的查询执行模型,并以 1994 年标准化其约定的论文命名。

首先我们有一个关系,我们通过 Scan 把它专为一个迭代器

let customer = [

{ id: 1, firstName: "justin", balance: 10 },

{ id: 2, firstName: "sissel", balance: 0 },

{ id: 3, firstName: "justin", balance: -3 },

{ id: 4, firstName: "smudge", balance: 2 },

{ id: 5, firstName: "smudge", balance: 0 },

];

function* Scan(coll) {

for (let x of coll) {

yield x;

}

}

接下来为他实现一些操作符

function* Select(p, iter) {

for (let x of iter) {

if (p(x)) {

yield x;

}

}

}

function* Map(f, iter) {

for (let x of iter) {

yield f(x);

}

}

function* Distinct(iter) {

let seen = new Set();

for (let x of iter) {

if (!seen.has(x)) {

yield x;

seen.add(x);

}

}

}

翻译我们的查询语句

SELECT DISTINCT customer_first_name FROM customer WHERE customer_balance > 0

Distinct(

Map(

(c) => c.firstName,

Select((c) => c.balance > 0, Scan(customer))

)

),

Push-Based 查询引擎

基于推送的查询引擎,有时也称为 Reactive、Observer、Stream 或回调地狱模型,如您所料,与我们之前的示例类似,但它颠覆了它。让我们从定义 Scan 开始

let customer = [

{ id: 1, firstName: "justin", balance: 10 },

{ id: 2, firstName: "sissel", balance: 0 },

{ id: 3, firstName: "justin", balance: -3 },

{ id: 4, firstName: "smudge", balance: 2 },

{ id: 5, firstName: "smudge", balance: 0 },

];

function Scan(relation, out) {

for (r of relation) {

out(r);

}

}

我们将“此运算符告诉下游运算符”构建为它需要调用的闭包。

剩下的运算符也是如此

function Select(p, out) {

return (x) => {

if (p(x)) out(x);

};

}

function Map(f, out) {

return (x) => {

out(f(x));

};

}

function Distinct(out) {

let seen = new Set();

return (x) => {

if (!seen.has(x)) {

seen.add(x);

out(x);

}

};

}

查询语句建模:

let result = [];

Scan(

customer,

Select(

(c) => c.balance > 0,

Map(

(c) => c.firstName,

Distinct((r) => result.push(r)),

),

),

);

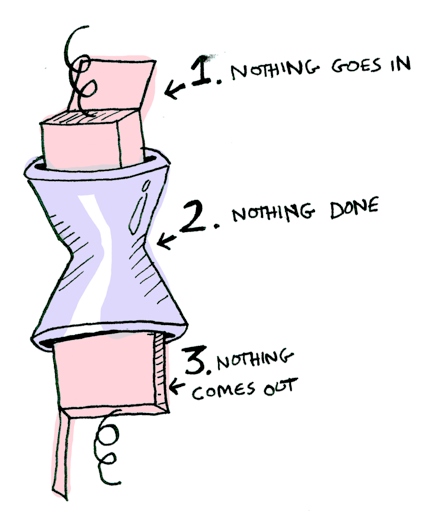

区别

在基于 Pull 的系统中,所有的操作符都是惰性的,只有当数据需要时,操作符才会开始计算(yield)。这也意味着系统的行为和用户的行为紧密耦合。

再基于 Push 的系统中,系统开始处于空闲状态,直到他接受到一行数据。因此系统的工作和消费者是解耦的。

基于 Push 的系统还需要创建一个缓冲区,并将查询结果放到里面。这就是基于 Push 的系统给人的感觉。它会假设消费者不存在,当被请求时,能够立即作出响应。

DAG, yo

SQL 中有一个 With 结构,它允许在查询中多次引用同一个结果集:

WITH foo as (<some complex query>)

SELECT * FROM

(SELECT * FROM foo WHERE c) AS foo1

JOIN

foo AS foo2

ON foo1.a = foo2.b

基于 Push 的系统能够优化查询结构,复用结果集,而基于 Pull 的系统无法做到这一点。

原文链接:https://www.youtube.com/watch?v=rDoqT-a6UFg

翻译:trdthg

选题:trdthg

可视化 Rust 各数据类型的内存布局

本文已获得作者翻译许可。由于译者个人能力有限,如有翻译错误,希望读者加以指正。 视频版翻译:B 站视频链接

// file: main.rs

fn main() {

println!("Hello World!");

}

当我们使用 Rust 中编写程序时,由于 Rust 的 生命周期和所有权模型,你最好为程序可能用到的数据结构做一些前期设计,不然 Rust 编译器可能让你十分痛苦。了解每个数据类型的内存布局有助于锻炼你的直觉,可以提前规避一些编译错误和性能问题。

在这个文章里,我们会讨论

- 在计算机运行二进制文件时发生了什么?

- 常见数据类型的内存布局 (包括:整形,元组,切片,向量,字符串,结构体,枚举,智能指针,特征对象,还有各种

Fn特征)

二进制数据段

当你编写一个 Rust 程序时,要么直接调用 rustc,要不就是通过 cargo 去生成一个可执行文件。

$ rustc main.rs

$ cargo build

这个二进制文件以一种特定的格式存储数据。对于 linux 系统,最常见的格式是 elf64 。不同的操作系统比如 linux, mac, windows

使用不同的格式。虽然二进制文件的格式不尽相同,但是它在各种的操作系统中的运行方式几乎相同。

常见的二进制文件一般由 文件头 + 分区 组成。对于 elf 格式的二进制文件,它的结构大致如下图所示:

段的数量根据编译器而不同。这里只展示了一些重要的一些段。

当你运行二进制文件时

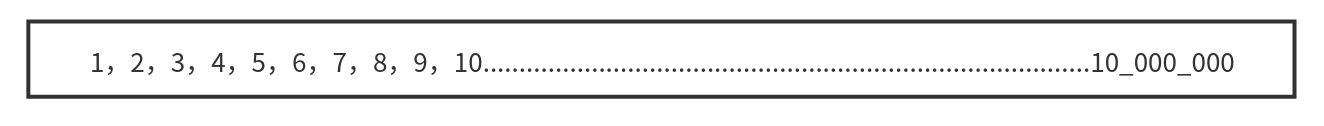

以 elf64 格式的二进制文件为例,在程序运行时,内核会为程序分配一段连续的内存地址,并将这些分区映射到内存中去。

注意:这里的内存地址并不是内存条里实际的内存地址。但是当程序开始使用内存时,内核和硬件会把它们映射到真正的物理内存地址。这被称为 虚拟地址空间。一个正在运行的程序被称为一个进程。从进程的角度来看,它只能看到一段连续的内存,从 0 到地址高位的最大值。

下面我们会介绍进程地址空间中各个区域的作用:

-

代码段 (text)

代码段包含了可执行指令的集合。

编译器能把我们用高级语言写的程序转换为 CPU 可以执行的机器指令,代码段就包含了这些指令。这些指令根据 CPU 架构而有所不同。编译给 x86-64 架构 CPU 运行的二进制文件不能在 ARM 架构的 CPU 上运行。

代码段是 只读 的,运行的程序不能更改它。

-

数据段 (data)

数据段包含 已经初始化 过的数据。比如全局变量,全局静态变量,局部静态变量。

-

BSS 段 (bss)

bss 代表

Block started by symbol, 这里保存着 未被初始化 过的全局变量。由于 bss 段的变量未被初始化,这一段并不会直接占据二进制文件的体积,它只负责记录数据所需空间的大小 -

地址高位

内核会把一些额外的数据,比如环境变量,传递给程序的参数和参数的数量映射到地址高位。

堆 & 栈

堆栈简介

当程序运行时(运行态),还需要需要另外两个域:堆和栈

栈:

-

操作系统使用栈存储一个进程的抽象细节,包括 (进程名字,进程 ID 等)。

-

一个进程至少有一个执行线程,每一个线程都有自己的栈内存。

-

在 64 位的 linux 系统上,Rust 程序为主线程分配 8MB 的栈内存。对于用户创建的其他线程,rust 标准库支持自定义大小,默认的大小是 2MB。

-

栈内存的空间会从地址高位向低位增长,但是不会超过线程可以拥有的最大值。对于主线程来说就是 8MB。如果它使用的栈内存超过了 8MB,程序就会被内核终止,并返回一个

stackoverflow错误。 -

栈内存被用于执行函数 (见下方对栈的具体讲解)。

虽然主线程的栈内存大小有 8MB,但是这 8MB 也不会被立即分配,只有当程序开始使用时,内核才会开始为它分配内存。

堆:

- 所有线程共享一块堆内存

- 堆内存从地址低位向高位增长。

操作系统通常会提供一些接口让我们检查程序运行时的内存映射状态,对于 linux 系统,你可以在 /proc/PID/maps 文件中查看

下面展示了一个进程的映射状态(部分):

$ cat /proc/844154/maps

55e6c3f44000-55e6c412c000 r-xp 00000000 103:03 22331679 /usr/bin/fish

55e6c412c000-55e6c4133000 r--p 001e7000 103:03 22331679 /usr/bin/fish

55e6c4133000-55e6c4134000 rw-p 001ee000 103:03 22331679 /usr/bin/fish

55e6c4134000-55e6c4135000 rw-p 00000000 00:00 0

55e6c4faa000-55e6c5103000 rw-p 00000000 00:00 0 [heap]

7fd62326d000-7fd62326f000 r--p 00034000 103:03 22285665 /usr/lib/ld-linux-x86-64.so.2

7fd62326f000-7fd623271000 rw-p 00036000 103:03 22285665 /usr/lib/ld-linux-x86-64.so.2

7ffecf8c5000-7ffecf8f5000 rw-p 00000000 00:00 0 [stack]

你可能会想问:堆内存和栈内存是否会相互覆盖?因为他们两个向对方的方向增长。

通过用 stack 的低位减去 heap 的高位

>>> (0x7ffecf8c5000 - 0x55e6c5103000) / (10 ** 12)

46.282743488512

差距为 47TB,所以栈堆冲突的情况几乎不可能出现

如果确实发生了,内核会提供守卫去终止程序。注意,这里的内存是指虚拟内存,并非电脑的真实内存大小。

CPU 字长

虚拟内存地址的范围由 CPU 字长 (word size) 决定,字长是指 CPU 一次可以并行处理的二进制位数,对于 64 位的 CPU 来说,它的字长为 64 位 (8 字节)。CPU 中大多数或者全部寄存器一般都是一样大。

因此可以得出:64 位 CPU 的寻址空间为 0 ~ 2^64-1。而对于 32 位的 CPU 来说,它的寻址空间只有从 0 到 2^32,大概 4GB。

目前,在 64 位 CPU 上,我们一般只使用前 48 位用于寻址,大小大概是 282TB 的内存

>>> 2**48 / (10**12)

281.474976710656

这其中,只有前 47 位是分配给用户空间使用,这意味着大概有 141TB 的虚拟内存空间是为我们的程序分配的,剩下的位于地址高位的 141TB

是为保留给内核使用的。如果你去查看程序的虚拟内存映射,你能使用的最大内存地址应该是 0x7fffffffffff

>>> hex(2**47-1)

'0x7fffffffffff'

栈内存

接下来让我们深入了解栈内存的用途

在这个例子中,整个程序只有一个主线程在运行,我们在 main 里调用了 add1 函数。

fn main() {

let a = 22;

let b = add_one(a);

}

fn add_one(i: i32) -> i32 {

i + 1

}

栈主要用来保存正在调用的函数的数据 (包括函数参数,函数的局部变量,和它的返回地址)。为一个运行中的函数分配的总内存被称为一个 栈帧。

-

main函数是程序的入口,首先main函数的栈帧被创建。main函数内部有一个两个i32类型的局部变量a和b,大小都是 4 个字节,其中a的值为 22。main函数的栈帧会确保有足够的空间去保存这些局部变量。ESP 和 EBP 寄存器内分别保存着栈顶指针和栈底指针,用来追踪当前的栈的顶部和底部。

-

当

main函数调用add1时,一个新的栈帧被创建用来保存add1函数的数据。栈顶指针被修改为新栈的顶部。

add1函数要接受一个i32类型的参数,因此 4 字节的空间会被保留在add1函数的栈帧上。add1函数并没有局部变量- 栈帧还会保存一个返回地址,当函数运行结束后,会根据该返回地址回到之前的指令。

-

函数调用结束

当函数调用结束后,就会把返回值 23 赋值给局部变量

b。同时栈顶指针也被修改。

注意:函数运行结束后,add1 的栈帧并没有被释放。当你的程序开始调用下一个函数时,新的栈帧会直接将其覆盖。对于栈来说,开辟和释放内存只需要修改栈指针即可。

由此可见,因为在栈上开辟和释放内存只需要移动指针,不需要进行任何系统调用,它的效率是很高的。

当然栈也有一些限制:

- 只有在编译时已知大小的变量才能被存储在栈上。

- 函数不能返回一个位于函数内部的局部变量的引用

如果你把 add_one 改成下面的样子,就会编译失败:

fn add_one(i: i32) -> &'static i32 {

let result = i + 1;

&result

}

error[E0515]: cannot return reference to local variable `result`

--> src/main.rs:8:5

|

8 | &result

| ^^^^^^^ returns a reference to data owned by the current function

根据我们之前介绍过栈的工作原理,假设你现在返回了一个函数内局部变量的引用,但是当函数返回时,本质上函数的内存就被释放了。当下一个函数被调用时,它的栈帧就会重写这块内存空间。

在一个带有 GC 的语言里,编译器能够检测到这种覆盖,并在会为这个变量在堆上分配一块空间,并返回它的引用。但是在堆上分配会带来部分额外开销。因为 Rust 没有 GC,而且不会强制你去显式的分配堆内存,所以这里会编译失败。

堆内存

在这个例子里,我们在 main 函数中调用了 heap 函数。

fn main() {

let result = heap();

}

fn heap() -> Box<i32> {

let b = Box::new(23);

b

}

首先会为两个函数再栈上创建栈帧。接着使用 box 将 23 分配在堆上。然后把 23 在堆上的地址赋值给了变量 b。box

只是一个指针,所以栈上有足够的空间去保存 box。

在 64 位系统上,指针的大小是 8 字节,所以在栈上的变量 b 的大小是 8 字节。而 b 指向的变量 23 是

i32类型,它在堆上只需要占用 4 字节。

当函数调用结束后,heap 函数返回的 box 指针就会被保存在 main 函数的局部变量里。

当你对栈上的数据进行赋值操作时,它的栈内存就会被直接 copy 过去。在这个例子里,用来保存 box 的 8 个字节就是从 heap

函数的栈帧直接复制到 main 的局部变量 result。现在即使 heap 函数的栈帧被释放,result

变量依然保存着数据的地址。堆允许你共享变量。

内存分配器

我们之前提到过每个线程都有各自的栈内存,他们共享一块堆内存。

假设你的程序不断在堆上分配新的数据,现在堆内存几乎耗尽了,需要对堆内存进行扩容。

程序的内存分配器一般会使用系统调用请求操作系统分配更多内存。对于 linux 系统来说,一般是 brk 或者 sbrk 系统调用。

在 Rust 里,堆内存分配器需要实现 GlobalAlloc 特征。你几乎不会直接用到它,编译器会在需要时插入合适的系统调用。

// /rust/library/std/src/sys/unix/alloc.rs

#[stable(feature = "alloc_system_type", since = "1.28.0")]

unsafe impl GlobalAlloc for System {

#[inline]

unsafe fn alloc(&self, layout: Layout) -> *mut u8 {

if layout.align() <= MIN_ALIGN && layout.align() <= layout.size() {

libc::malloc(layout.size()) as *mut u8

}

...

}

...

}

你可能很熟悉 C 语言里的 malloc 函数,但是它并不是系统调用,malloc 依然会调用 brk 或者 sbrk 去请求内核。Rust

的内存分配器依靠 C 标准库里提供的 malloc 函数,如果你使用像 ldd 这样的工具去检查二进制文件依赖的动态链接库,你应该会看到 libc

$ ldd target/debug/demo

linux-vdso.so.1 (0x00007fff60bd8000)

libc.so.6 => /usr/lib/libc.so.6 (0x00007f08d0c21000)

/lib64/ld-linux-x86-64.so.2 => /usr/lib64/ld-linux-x86-64.so.2 (0x00007f08d0ebf000)

Linux 下 Rust 默认使用 GNU 作为链接器,因此 Rust 二进制文件依赖于操作系统上的 C 标准库或者

libc库。libc更像是操作系统的一部分,使用像libc这样的动态链接库有助于减少二进制文件体积。

同时,内存分配器也不总是依赖于系统调用在堆上分配内存:

-

每次程序使用 box 等把数据分配在堆上时,程序的内存分配器都会成块的请求内存去减少系统调用的次数。

-

堆和栈不一样,内存不一定总是在堆的末尾被释放。当一些地方的内存被释放后,它并没有立即返还给操作系统,内存分配器会追踪内存分页,知道那些页正在使用,那些页被释放了。所以当需要更多堆内存时,它可以直接使用这些已经释放但还未归还的内存分页。

现在你应该知道为什么分配堆内存比栈内存更消耗性能了。分配堆内存可能使用到系统调用,而且内存分配器每一次分配内前,都必须从堆上找到一个空闲内存块。

Rust 各数据类型的内存布局

整形

| 长度 (byte) | 长度 (bit) | 有符号 | 无符号 |

|---|---|---|---|

| 1 字节 | 8 位 | i8 | u8 |

| 2 字节 | 16 位 | i16 | u16 |

| 4 字节 | 32 位 | i32 | u32 |

| 8 字节 | 64 位 | i64 | u64 |

| 16 字节 | 128 位 | i128 | u128 |

有符号和无符号整形的名字已经展示了它所占的位数,比如 i16 和 u16 在内存都是 16 位 (2 字节)。它们都被完整的分配在函数的栈帧上。

isize 和 usize 的大小则取决于你的系统,32 位系统就占用 4 字节,64 位系统就占用 8 字节。

字符型

char Rust 的字符不仅仅是 ASCII,所有的 Unicode 值都可以作为 Rust 字符。例如

a、\u{CA0}、*、字、\n、🦀

char 类型长度是 4 字节,直接分配在栈上

元组

元组是一些类型的集合

let a: (char, u8, i32) = ('a', 7, 354);

比如这里,变量 a 包含了 char, u8, i32 三种数据类型,它的内存布局就是将各个成员依次排列。

在这里 char 占用 4 字节,u8 占用 1 字节,i32 占用 4 字节。因为这三种类型都是只在栈上分配的,所以整个元组也全在栈上分配。

虽然看起来这个元组只会占用 9 字节的空间,但是其实并不是这样,你可以用 size_of 去查看这个元组占用的真正字节数

std::mem::size_of::<T>()

size_of 和 align_of

use std::mem::{size_of, align_of};

size_of::<(char, u8, i32)>(); // 12 字节

align_of::<(char, u8, i32)>(); // 4 字节

所有的数据类型还有一个对齐属性,你可以通过 align_of 查看。

数据类型的大小必须是对齐属性的整数倍。这一点不仅仅是 Rust,所有的编译器都是这样。数据对齐对 CPU 操作及缓存都有较大的好处,有助于 CPU 更快的读取数据。

对于这个元组,它的对齐属性值是 4,因此它占用的字节数是 12。剩下的 3 字节会被编译器填充空白数据

引用

接下来是引用类型 &T

let a: i32 = 25;

let b: &i32 = &a;

a 是 i32 类型,b 是对 a 的引用。

接下来,我不会在详细展示每个数据的字节大小,我们将重点去关注整体,关注他们是存储在堆上还是栈上。

在这里,a 存储在栈上,它占据 4 个字节。b 也存储在栈上,里面保存了变量 a 的地址。引用类型的大小取决于你的机器位数,所以 64 位系统上它占

8 字节。

如果我们再用 c 保存 b 的引用,c 的类型就是 &&i32

let c: &&i32 = &b;

引用也能指向堆上的数据。

可变引用也有相同的内存布局。

可变引用和不可变引用的区别是他们的使用方式,以及编译器为可变引用添加的额外限制。

数组

let a: [i32; 3] = [55, 66, 77];

一个数组的大小是固定的,而且它的大小是数据类型的一部分。数组中的每个元素都会在栈上相邻排放。但是当数组创建后,它的大小就不能再改变。

注意:只有大小固定而且在编译时已知的数据类型才能存储在栈上。

Vec

Vec 类型是可扩容的,它的大小能够改变,你可以用它代替数组。

let v: Vec<i32> = vec![55, 66, 77];

这里我们的变量 v 存储了和数组相同的数据,但是它是在堆上分配的。

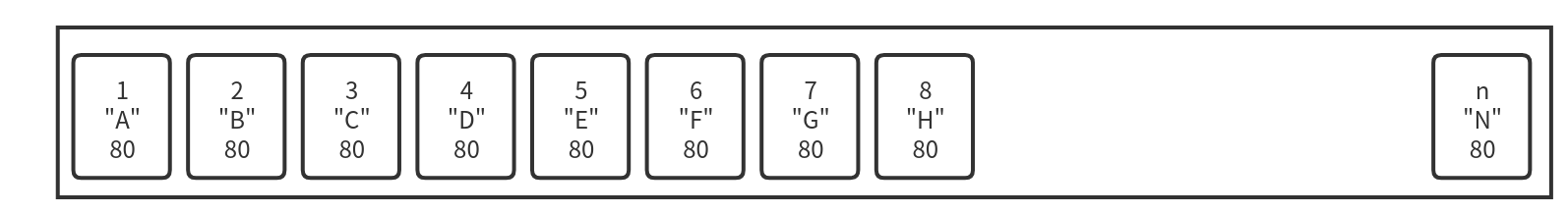

变量 v 在栈上占用的大小是固定的,包含 3 个 usize:

- 第一个表示数据在堆上的地址,

- 剩下的两个表示 Vec 的容量和长度。

容量表示 Vec 的最大空间。当我们向 Vec 中添加更多数据时,如果元素个数还没有达到容量大小,Rust 就不必为堆内存分配更多空间。

如果长度和容量已经相等了,我们还要向 Vec 添加更多数据,Rust 就会在堆中重新分配出一块更大的内存,将原数据复制到新的内存区域,并更新栈中的指针。

切片

let s1: [i32] = a[0..2];

let s2: [i32] = v[0..2];

切片 [T] 和数组非常相似,但是不用指定大小。切片就像是底层数组的一个视图,s1 表示数组 a 的前两个元素,s2 表示向量的前两个元素。

由于切片没有指定元素数量,编译时 Rust 编译器不知道它具体占了多少字节。同时,你也不能将切片存在变量中,因为它没有已知大小,所以不能被分配在栈上,这样的类型被称为 DST 动态大小类型 。

还有其他的 DST 类型,比如字符串切片和特征对象。

如果你尝试运行上面的代码,应该会编译失败:

error[E0277]: the size for values of type `[i32]` cannot be known at compilation time

--> examples/vec.rs:8:9

|

8 | let s1: [i32] = a[0..2];

| ^^ doesn't have a size known at compile-time

|

help: consider borrowing here

|

8 | let s1: [i32] = &a[0..2];

| +

因此,几乎在任何情况下,我们只会使用到切片的引用 &[T]。被引用的数据既能在栈上,也能在堆上:

我们之前说过,引用只是一个指针,它占据一个 usize 去存储它所指向的数据的地址。

但是当你用指针去指向一个动态大小类型时 (比如切片),Rust 会使用一个额外的 usize 去存储数据的长度。这种引用也叫做 胖指针

(将一些附加信息和指针一起存储)。

切片引用可以用两个 usize 表示,所以它可以存在栈上。

字符串

与字符串相关的有三种类型:String, str, &str,他们分别对应 Vec, [T], &[T}

字符串类型 String 的内存布局和向量相同,唯一的区别是,字符串类型必须是 UTF-8 编码。

以下面的代码为例:

let s1: String = String::from("hello");

但是,如果你把一个字符串直接保存在变量中:

let s2: &str = "hello";

s2 的类型就会变成字符串切片的引用,这个字符串的数据不会在堆上,而是直接存储在编译好的二进制文件中。这种字符串有 'static

的生命周期,它永远不会被释放,在程序运行时都是可用的。

据我所知,Rust 不会指定字符串被保存在文件的那个部分,但是很可能就在代码段 (text segment)

和切片引用一样,对字符串的切片的引用也是一个胖指针,包含两个 usize,一个用来存储字符串的内存起始地址,另一个存储字符串长度。

你不能直接使用字符串切片 str:

// error: size can not be known at compile time

let s: str = s1[1..3];

对字符串的切片引用是可行的:

let s: &str = &s1[1..3];

结构体

Rust 有三种结构体类型:结构体,元组结构体 (Tuple Struct) 和单元结构体 (Unit-like Struct)。

普通结构体:

struct Data {

nums: Vec<usize>,

dimension: (usize, usize),

}

元组结构体:

struct Data(Vec<usize>);

单元结构体:

struct Data;

单元结构体不保存任何数据,所以 Rust 编译器甚至不会为他分配内存。

另外两种结构体的内存排布非常类似于之前所说的元组,我们以普通的结构体为例:

struct Data {

nums: Vec<usize>,

dimension: (usize, usize),

}

它有两个字段,一个 Vec 和一个元组,结构体的各个成员会在栈上依次相邻排列。

- Vec 需要占用 3 个

usize,nums 的成员会被分配在堆上。 - 元组需要占用 2 个

usize。

注意:我们在这里忽视了内存对齐和编译器填充的 padding。

枚举

像结构体一样,Rust 支持用不同的语法表示枚举。

下面展示的是一个 C 风格的枚举,在内存中他们被保存为从零开始的整数,Rust 编译器会自动选择最短的整数类型。

enum HTTPStatus {

Ok,

NotFound,

}

在这里最大值为 1,因此该枚举可以使用 1 字节存储。

你也可以手动为枚举的每个变体指定它的值:

enum HTTPStatus {

Ok = 200,

NotFound = 404,

}

这个例子里最大的数是 404,需要至少 2 字节存储。所以这个枚举的每种变体都需要 2 字节。

枚举值也可以选择具体的类型

enum Data {

Empty,

Number(i32),

Array(Vec<i32>)

}

在这个例子中

Empty变体不存储任何数据Number内部有一个i32Array里面有个Vec

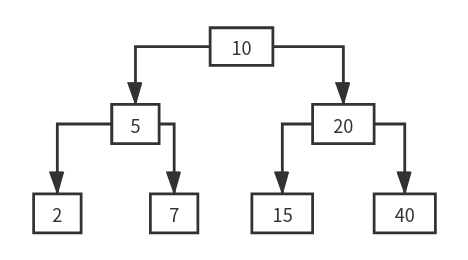

它们的内存布局如下图所示:

首先我们看 Array 变体:

首先是一个整数标记 2 占用 1 字节,接着就是 Vec 所需的三个 usize ,编译器还会填充一些空白区域让他们内存对齐,所以这个变体需要 32

字节 (1 + 7 + 3 * 8)。

接着是 Number 变体,首先是整数标记 1,接着是 Number 里存储的 i32,占用 4

字节。因为所有变体的大小应该是一致的,所以编译器会为它们两个都添加 Padding 达到 32 字节

对于 Empty,它只需要一个字节去存储整数标记,但是编译器也必须添加 31 字节的 Padding

所以,枚举占用的空间取决于最大变体占用的空间。

减少内存使用的一个技巧就是降低枚举最大变体占用的内存:

enum Data {

Empty,

Number(i32),

Array(Box<Vec<i32>>) // 使用 Box 代替

}

在这个例子里,我们存除了 Vec 的指针,此时 Array 变体需要的内存只有 16 字节:

Box

Box 是一个指针指向堆上的数据,所以 Box 在栈上只需要 1 个 usize 去存储地址。

在上个例子中,Box 指向了一个在堆上分配的 Vec。

如果向量里面有值,这些值也会被存储在堆上。指向数据的指针将保存在 Vec 的指针字段里

对 Option 的优化

pub enum Option<T> {

None,

Some(T)

}

由于 Rust 不允许出现空指针,想要实现同样的效果,你需要使用

Option<Box<i32>>

这能够让 Rust 编译器确保不会出现空指针异常。

在其他语言里,使用一个指针就能表示这两种状态。但是 Rust 却需要一个额外的整数标记和随之带来的 padding,这会造成内存浪费。

编译器能对此做出一些优化,如果 Option 里是 Box 或者是类似的指针类型,编译器就会省略掉整数标记,并使用值为 0 的指针表示 None。

这种特性使得 Rust 中被包装在 Option 内的智能指针像其他语言里的指针一样,不会占用多余的内存。同时还能够提前找到并消除空指针异常

Copy 和 Move

在继续向下讨论之前,让我们先了解一下 Copy 和 Move

let num:i32 = 42;

let num_copy = num;

对于原始类型数据,他们的大小是在编译时已知的,会被存储在栈上。如果你将一个变量赋值给另一个变量,它得到的实际上是原始数据的一份拷,Rust 会逐位进行复制。

这两个变量之后能同时使用

对于在堆上存储的数据来说:

let v: Vec<String> = vec![

"Odin".to_String(),

"Thor".to_String(),

"Loki".to_String(),

]

在这个例子里,我们有一个在堆上分配的字符串向量。

变量 v 被保存在栈上,它需要 3 个 usize 去存储 Vec 的信息,并指向数据在堆中的地址。

每个字符串也需要 3 个 usize 来存储实际字符串的信息。

真正的字符串会被分配到堆上的其他地方。

从所有权角度来说,变量 v 拥有所有在堆上分配的内存。因为 Rust 没有 GC,当变量 v 自己超出作用域后,它需要自己释放自己拥有的堆内存。

接下来我们将 v 赋值给了 v2:

let v2 = v;

对于有 GC 的语言来说,程序会对变量 v 在栈上的数据进行了按位复制,最后 v2 也将拥有指向堆上数据的指针。

这种方案很节省内存,无论在堆中的数据有多大,我们只需要复制栈上的数据。垃圾回收器会追踪堆内存的引用数量,当引用计数归零,垃圾回收器会帮我们释放堆内存。

但是 Rust 没有 GC,它只有所有权模型。我们不清楚到底哪个变量需要对释放内存负责。

另一种方案是:在赋值时为堆内存也创建一个副本。但是这会导致内存使用量升高,降低性能。

Rust 的选择是让用户必须做出选择:如果你在对变量赋值时想让它拥有一份属于自己的堆内存,你应该使用 clone 方法。如果你不使用 clone

方法,Rust 编译器就不允许你再使用之前的变量。

我们把它称为:变量 v 已经被 move 了,现在 v2 是数据的拥有者。当 v2 超出作用域时,它会负责释放堆上的数据。

Rc

有时候我们想让一个值拥有多个拥有者,大多数情况下,你可以用普通的引用去解决。但是这种方法的问题在于,当数据的拥有者超出作用域后,所有的引用也不能再继续使用。

我们想要的是所有变量都是数据的拥有者,只有所有变量都超出作用域后,数据才会被释放。Rc 智能指针通过引用计数能够实现这个功能:

use std::rc::Rc;

let v: Rc<Vec<String>> = Rc::new(vec![

"Odin".to_String(),

"Thor".to_String(),

"Loki".to_String(),

]);

let v2 = v.clone();

println!("{}, {}", v.capacity(), v2.capacity())

当你使用 Rc 去包裹一个 Vec 时,Vec 的 3 个 usize 会和引用计数一起分配在堆上。变量 v 在栈只占用一个 usize,里面存储了

Rc 在堆上的地址。

现在你能通过克隆 v 来创建 v2,这个克隆不会克隆任何位于堆上的数据,他只会克隆一份栈上的地址,然后将 Rc 的引用计数加 1,现在 v 和 v2 都持有相同的一份数据,这就是为什么它被称为引用技术指针。

但是 Rc 也有限制,Rc 内部的数据是不可变的,你可以使用内部可变性可以解决这个问题。

每当有一个共享者超出作用域,引用计数就会减 1,让引用计数减到 0 时,整个堆内存就会被释放。

Send 和 Sync

Rust 有一些特殊的标记特征,例如 Send 和 Sync。

如果一个类型实现了 Send,那就意味着数据可以从一个线程移动到另一个线程。

如果一个类型实现了 Sync,多个线程就可以使用引用去共享该数据。

Rc 没有实现 Send 和 Sync。假设两个线程在某个时间点同时拥有对某数据的引用,并且同时对该引用进行克隆。两个线程同时更新引用计数就会引发线程安全问题。

Arc

如果你真的想要在线程间共享数据,你应该使用 原子 引用计数指针 Arc。

Arc 的工作方式几乎和 Rc 相同,只是引用计数的更新是原子性的,它是线程安全的。但是原子操作会带来一些微小的性能损耗。如果你只需要在单线程内共享数据,使用 Rc 就够了。

默认情况下 Arc 也是不变的,如果你想让数据是可变的,你可以使用 Mutex。

// Arc<Mutex<T>>

let data: Arc<Mutex<i32>> = Arc::new(Mutex::new(0));

现在即使有两个线程尝试同时修改数据,他们需要首先获取锁,同时只有有一个线程能拿到锁,因此只能由一个线程修改数据。

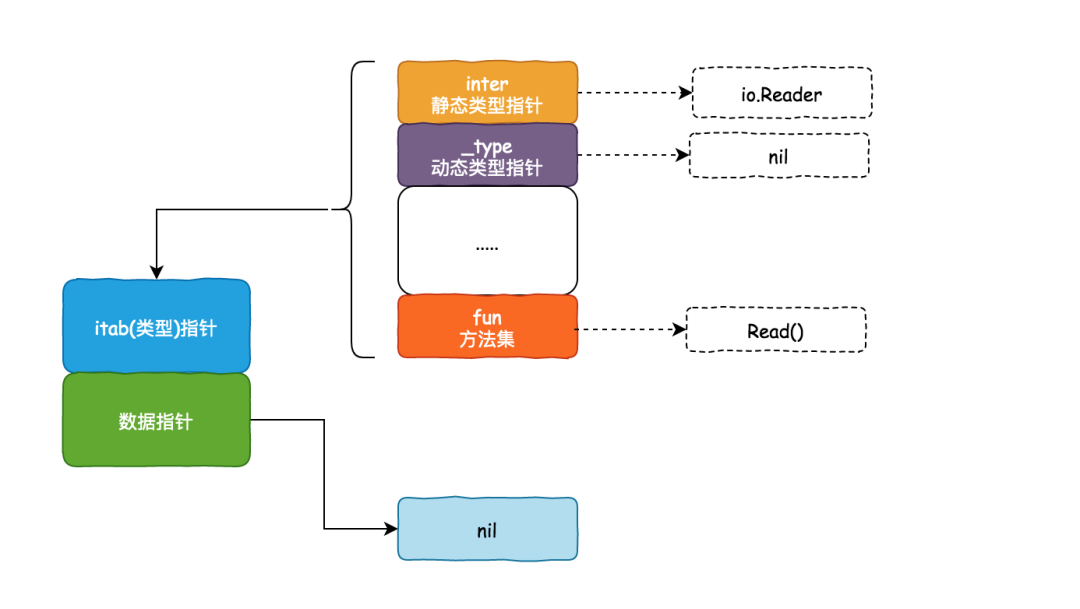

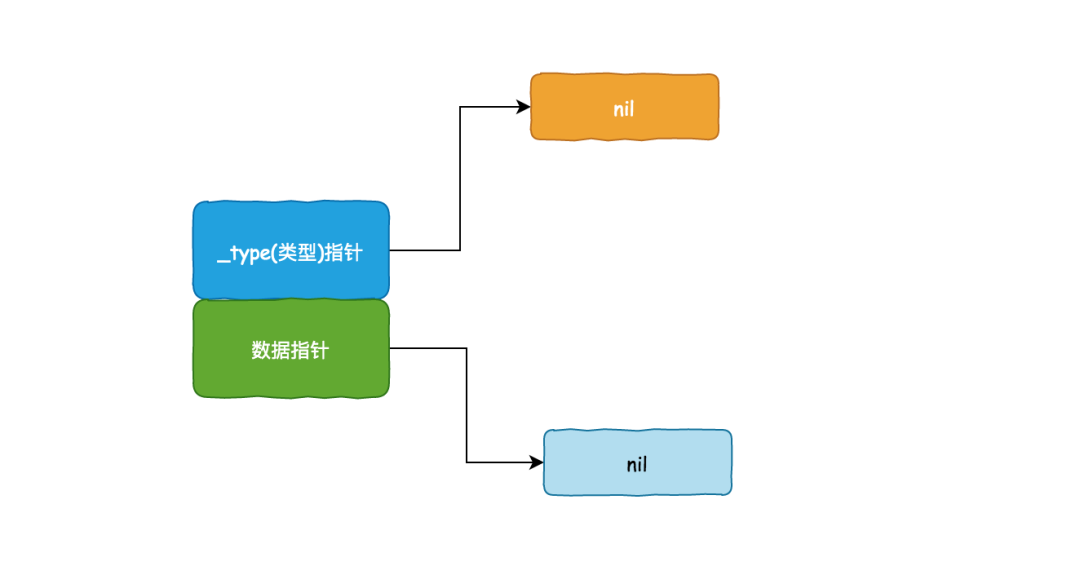

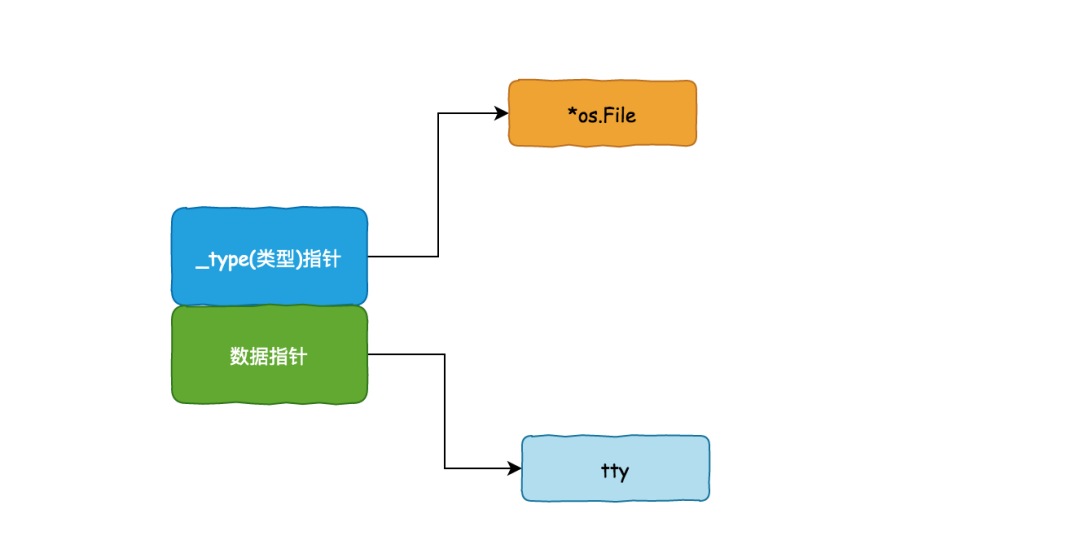

特征对象

实现了特征的实例被称为特征对象。

下面列举了将一种具体类型转化为特征对象的方法:

#![allow(unused)] fn main() { use std::io::Write; let mur buffer: Vec<u8> = vec![]; let w: &mut dyn Write = &mut buffer; }

第一个例子中,转化发生在为变量 w 赋值时

fn main() {

let mut buffer: Vec<u8> = vec![];

writer(&mut buffer);

}

fn writer(w: &mut dyn Write) {

// ...

}

第二个例子中,转化发生在将具体类型变量传递给接受特征对象的函数时

这两个例子里 Vec<u8> 类型的变量都被转化为实现了 Write 的特征对象。

Rust 用胖指针表示一个特征对象。该胖指针由两个普通指针组成,占用 2 个机器字长。

- 第一个指针指向值,这里就是

Vec<u8> - 另一个指针指向 vtable (虚表)。

vtable 在编译时生成,被所有相同类型的对象共享。vtable 包含了实现 Writer

必须实现的方法的指针。当你在调用特征对象的方法时,Rust 自动使用 vtable 找到对应的方法。

注意:dyn Write 也是动态大小类型,因此我们总是使用它的引用,即 &dyn Write。

我们能把 Vec<u8> 转换成特征对象是因为标准库已经为它实现了 Write 特征。

impl Write for Vec<u8>

Rust 不仅能将普通引用转化为特征对象,rust 也能将智能指针转换为特征对象:

// Box

use std::io::Write;

let mut buffer: Vec<u8> = vec![];

let w: Box<dyn Write> = Box::new(buffer);

// Rc

use std::io::Write;

use std::rc::Rc;

let mut buffer: Vec<u8> = vec![]

let mut w: Rc<dyn Write> = Rc::new(buffer);

无论是普通引用还是智能指针,在转换发生的时候,Rust 只是添加了适当的 vtable 指针,把原始指针转换为了一个胖指针。

函数指针

函数指针只需要一个 usize 去存储函数的地址。

test_func 是一个会返回 bool 的函数,我们可以把它存在了一个变量里。

fn main() {

let f: fn() -> bool = test_func;

}

fn test_func() -> bool {

true

}

闭包

Rust 没有具体的闭包类型,它制定了 3 个特征 Fn、FnMut、FnOnce。

FnOnce

首先是 FnOnce,create_closere 函数返回了一个实现 FnOnce 的对象

fn main() {

let c = create_closure();

}

fn create_closure() -> impl FnOnce() {

let name = String::from("john");

|| {

drop(name);

}

}

在函数体内部我们创建了一个局部变量 name,它是字符串类型,在栈上占据 3 个 usize

,接着又创建了一个闭包,闭包可以捕获函数内的局部变量。在闭包内部,我们 drop 了 name。

FnOnce 只是一个特征,它只定义了一个对象的行为或方法。Rust 内部会使用结构体表示闭包,它会根据闭包捕获的变量创建对应的结构体,并为该结构体实现最合适的特征

struct MyClosure {

name: String

}

impl FnOnce for MyClosure {

fn call_once(self) {

drop(self.name)

}

}

FnOnce特征的真实函数签名比较复杂,这里只展示一个简化版本。

结构体内部只有一个 name 字段,是闭包从 create_closure 函数内部捕获而来,call_once 是 FnOnce

特征必须实现的方法。因为闭包对应的结构体只有一个 String 类型字段,所以他的内存布局和 String 一样。

注意 call_once 函数的参数,他需要一个 self ,这意味着 call_once

只能调用一次。原因也很简单,如果我们调用两次这个闭包,拿他就会 drop name 两次。

FnMut

在这个例子里,我们创建了一个可变的闭包:

let mut i: i32 = 0;

let mut f = || {

i += 1;

};

f();

f();

println!("{}", i); // 2

这个闭包的类型是 FnMut ,因为我们在闭包里尝试修改变量 i。因此该闭包生成的结构体中将会有一个对变量 i 的可变引用,call_mut

方法也需要一个对 self 的可变引用:

struct MyClosure {

i: &mut i32

}

impl FnMut for MyClosure {

fn call_mut(&mut self) {

*self.i += 1;

}

}

如果你在闭包 f 改为不可变的:

let f = || {

i += 1;

};

就会编译失败:

error[E0596]: cannot borrow `f` as mutable, as it is not declared as mutable

--> src/main.rs:16:5

|

12 | let f = || {

| - help: consider changing this to be mutable: `mut f`

13 | i += 1;

| - calling `f` requires mutable binding due to mutable borrow of `i`

...

16 | f();

| ^ cannot borrow as mutable

For more information about this error, try `rustc --explain E0596`.

错误信息提示我们,该闭包需要设为可变的

Fn

最后是 Fn 特征:

fn create_closure() {

let msg = String::from("hello");

let my_print = || {

println!("{}", msg);

};

my_print();

my_print();

}

在这个例子里,我们的闭包只是打印了一下它捕获到的 msg 变量,print 宏接受的是变量的引用,所以 Rust 会自动为闭包实现 Fn 特征:

struct MyClosure {

msg: &String,

}

impl Fn for MyClosure {

fn call(&self) {

println!("{}", self.msg);

}

}

生成的结构体内部只有一个对 msg 的引用。call 方法只需要一个 self 的引用,因此这个闭包能够被多次调用。

move

这个例子中我们将使用和刚刚相同的闭包,只不过是用一个函数去返回:

fn create_closure() -> impl Fn() {

let msg = String::from("hello");

|| {

println!("{}", msg);

}

}

但是这样会编译错误:

error[E0597]: `msg` does not live long enough

--> src/main.rs:30:24

|

29 | || {

| -- value captured here

30 | println!("{}", msg);

| ^^^ borrowed value does not live long enough

31 | }

32 | }

| -- borrow later used here

| |

| `msg` dropped here while still borrowed

For more information about this error, try `rustc --explain E0597`.

错误信息提示我们,变量 msg 的生命周期可能比闭包短。

现在回想一下闭包的内存布局,闭包的结构体内部只有一个对 msg 的引用。所以当函数调用结束后,它的栈帧将被释放,闭包就不能再引用到该函数栈帧里的局部变量。

Rust 希望我们使用 move 关键字去明确表示我们想让闭包拿走闭包捕获到的变量的所有权

fn create_closure() -> impl Fn() {

let msg = String::from("hello");

move || {

println!("{}", msg);

}

}

当我们使用 move 之后,闭包的结构体就不再是引用,而是字符串本身。

struct MyClosure {

msg: String,

}

impl Fn for MyClosure {

fn call(&self) {

println!("{}", self.msg);

}

}

捕获多个变量

到目前为止,我们的闭包还只是捕获一个变量,在这个例子里闭包捕获了两个对象,一个字符串和一个 Vec:

fn create_closure() -> impl Fn() {

let msg = String::from("hello");

let v: Vec<i32> = vec![1, 2];

move || {

println!("{}", msg);

println!("{:?}", v);

}

}

它的结构体大致如下:

struct MyClosure {

msg: String,

v: Vec<i32>,

}

impl Fn for MyClosure {

fn call(&self) {

println!("{}", self.msg);

println!("{:?}", self.v);

}

}

它的内存布局和结构体的一样,并没有什么特殊的。

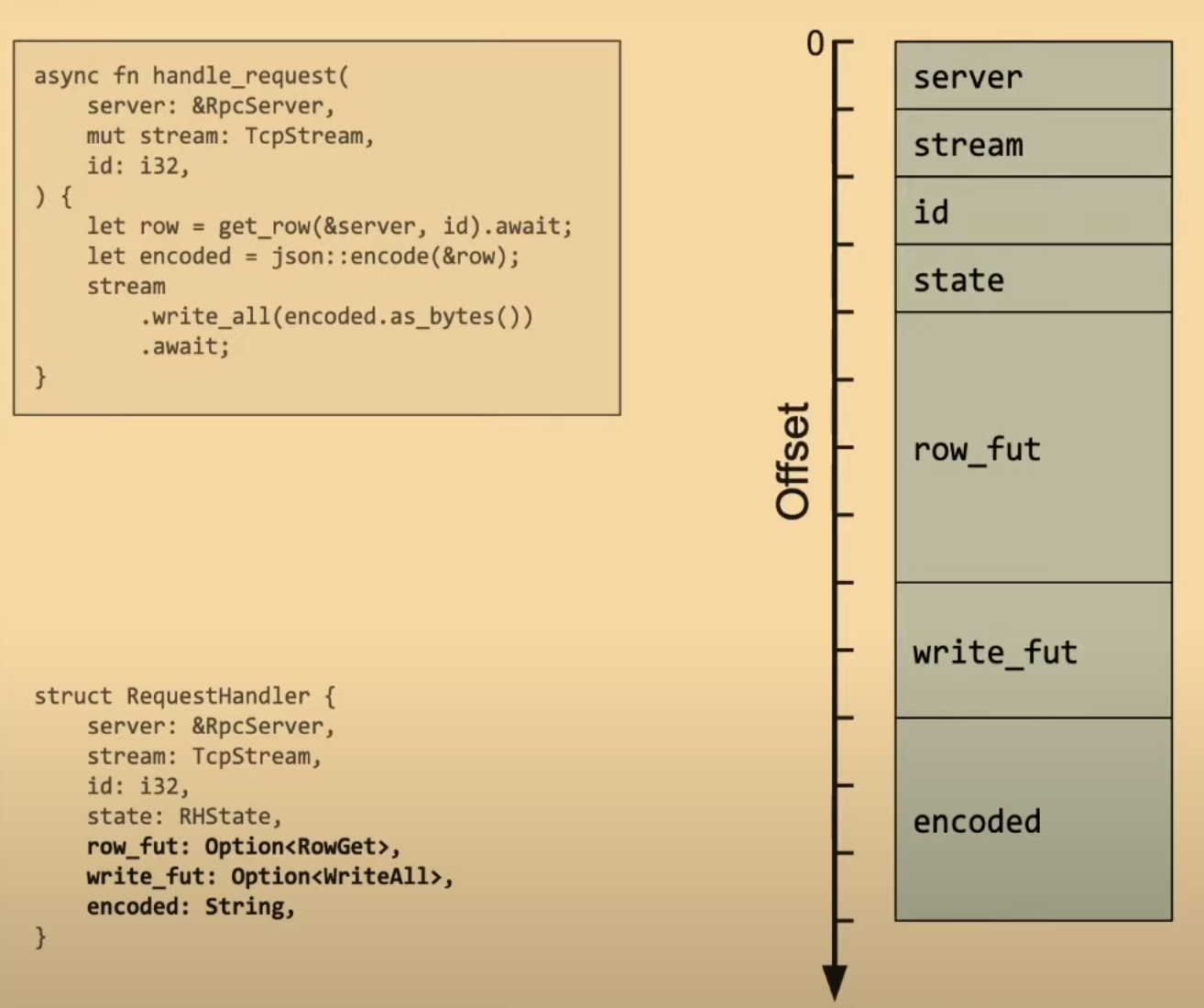

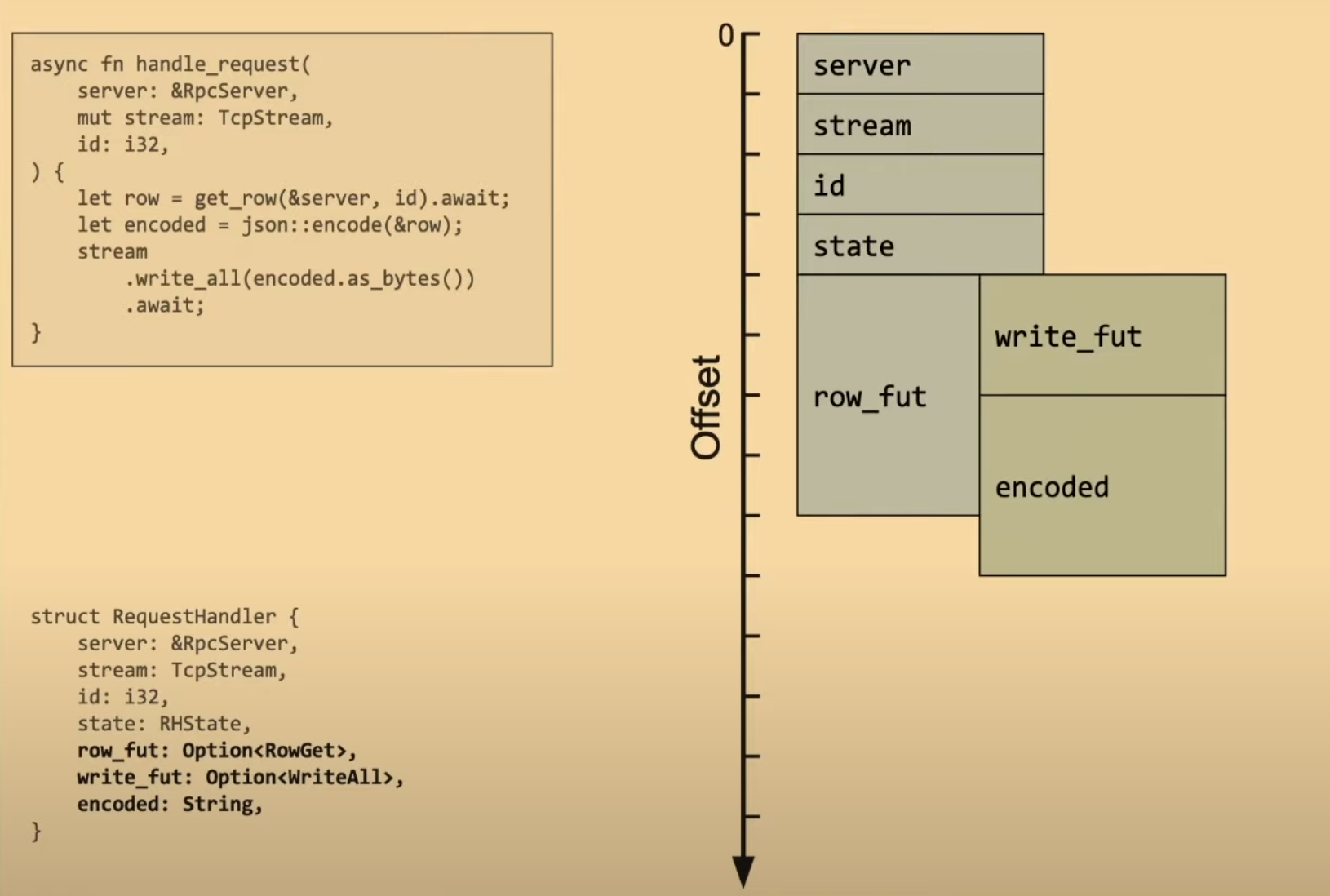

这个模式在其他地方也遵循,比如 异步生态中大量使用的 Future 特征。在内存中编译器会使用枚举表示实际的对象,并为这个枚举实现 Future 特征。这里不会详细讲解 Future 的实现细节,我提供了一个链接,视频里详细的解释了异步函数的实现细节。

资料

- 异步函数的一生 RustFest Barcelona - Tyler Mandry: Life of an async fn

- 堆栈 KAISER: hiding the kernel from user space

- 虚拟地址空间 Virtual address spaces

对重请求 - 应对尾部延迟

Hedged requests — Tackling tail latency

通常出现在出现在分布式系统中,实现分布式系统有很多优缺点

使用分布式系统的常见原因:

- 可用性

- 可扩展性

- 分区容错

- 独立部署

- 为不同目的使用不同的技术

这些可能是分布式系统的问题:

- 成本

- 复杂

- 一致性

- 延迟

我们将重点关注延迟,更具体地说是尾部延迟。

延迟

当我们使用分布式系统时,延迟会不可避免的增加。分布式系统中的每一跳都不是免费的,除了网络延迟还有其他成本,如果使用 HTTP 通信,我们还要处理消息、解析消息、验证身份令牌、以及我们想要添加到管道中的任何数据。这些是在设计分布式系统时需要考虑的问题。我们必须考虑是否有必要分发新的系统。

要回答这个问题,我们需要了解如何测量延迟。最简单的答案之一是使用百分比。

百分比

首先是定义我们的观察组。对于延迟,最常见的观察组是给定请求类别的响应时间。计算的方式如下:

- 获取请求的所有响应时间并排序。

- 取前 x% 的元素。

- 获取集合的最大(最长)值。

以请求 /hello-world 接口为例

- 获取请求的所有响应时间并排序。

- 获取响应时间:23, 20, 21, 20, 23, 20, 45, 21, 25, 25

- 排序:20, 20, 20, 21, 21, 23, 23, 25, 25, 45

- 取前 50% 元素:20, 20, 20, 21, 21

- 得到最大值:21

所以 P50 就是 21 ms,如果取前 90 % 元素,P90 就是 25 ms

尾部延迟

尾部延迟是百分位谱最末端的延迟。一般系统对 99% 的请求的响应都很快,但是对于剩下的 1% 可能非常差。

对于一个每分钟接受数百万请求的系统来说,这 1% 就不是微不足道了

对于一个每分钟接受数百万请求的系统来说,这 1% 就不是微不足道了

2013 年 Google 发表的论文介绍了一些解决方法

- Hedged requests

- Tied requests

- Micro partitions

- Selective replication

- Latency-induced probation

- Good enough responses

- Canary requests

P99 = 140ms P95 = 70ms

剩下的 5% 请求占了总请求一半的延迟

对冲请求

如果请求的时长超过 P95 还没有结果,那么就重发

模拟尾部延迟

下面的代码模拟了有 %4 的请求会等待 100ms

package main

import (

"math/rand"

"net/http"

"time"

"github.com/gorilla/mux"

)

func main() {

router := mux.NewRouter()

router.HandleFunc("/ishealthy", func(w http.ResponseWriter, r *http.Request) {

rd := rand.New(rand.NewSource(time.Now().UnixNano()))

requestPercentile := rd.Intn(100)

waitTime := 0

if requestPercentile > 96 {

waitTime = 100

}

time.Sleep(time.Duration(waitTime+15) * time.Millisecond)

w.WriteHeader(http.StatusOK)

w.Write([]byte("Healthy"))

}).Methods(http.MethodGet)

http.ListenAndServe(":8080", router)

}

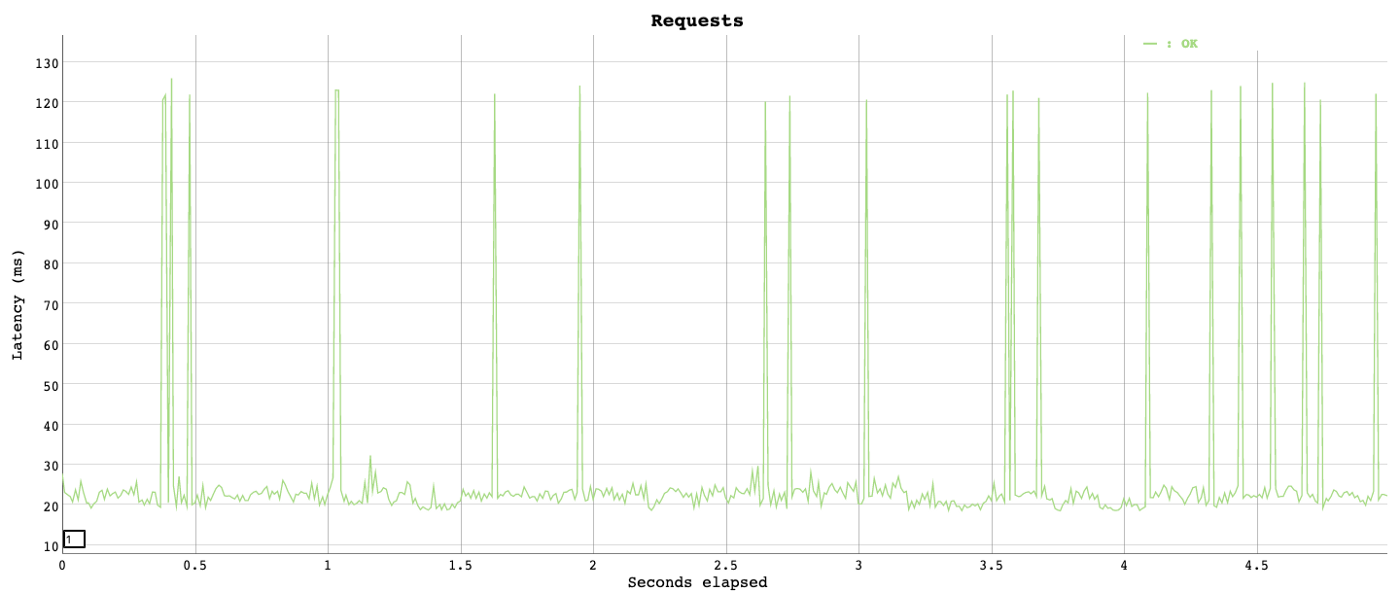

从图中可以看到

从图中可以看到

- p50 小于 20ms

- p95 20ms 左右

- p99 超过 115ms

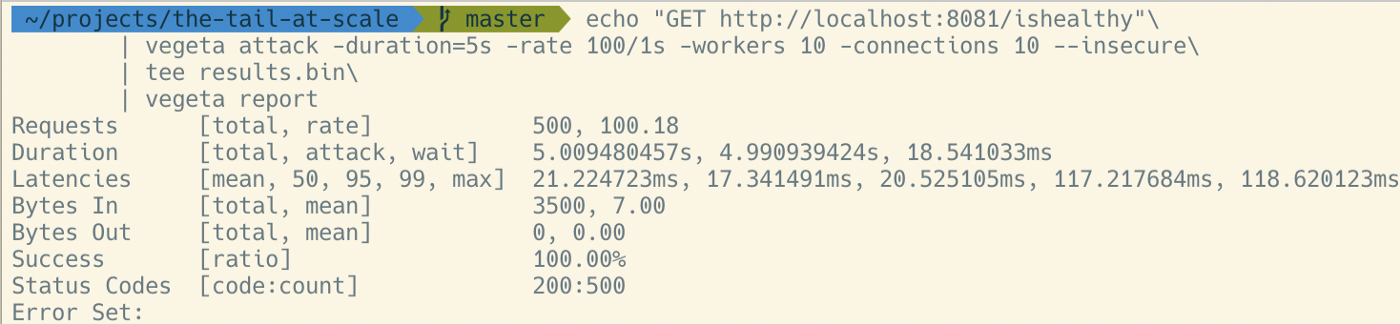

对重测试

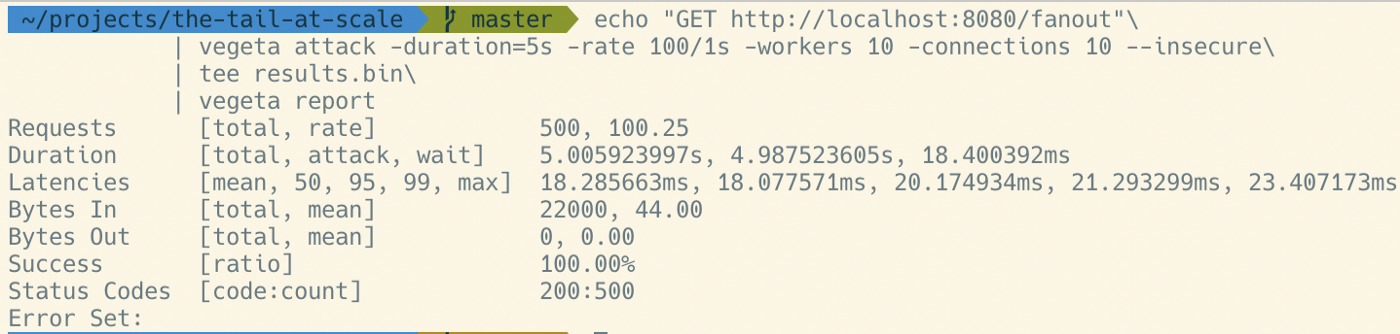

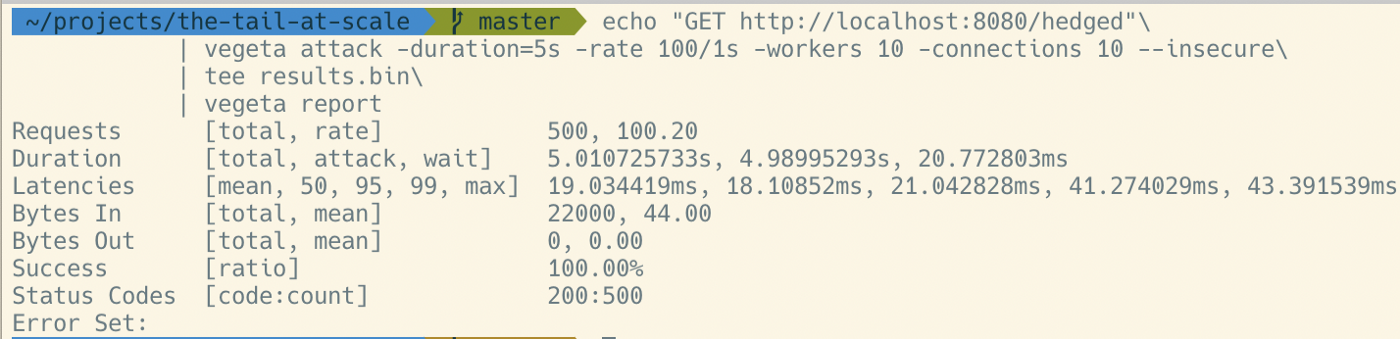

新增两个接口

/falout:对于每个请求都转发出 3 个副本。应该能到达 P99 性能。但会发出 3 倍以上的请求。/hedged:在第一个未达到预期 P95 (21ms) 之后触发对冲请求。应该在 40 毫秒左右将尾部性能提高到 P99。最多只能多发出 5% 的请求。

falout

func queryFanOut(urls []string) string {

ch := make(chan string, len(urls))

for _, url := range urls {

go func(u string) {

ch <- executeQuery(u)

}(url)

}

return <-ch

}

hedged

func queryWithHedgedRequests(urls []string) string {

ch := make(chan string, len(urls))

for _, url := range urls {

go func(u string, c chan string) {

c <- executeQuery(u)

}(url, ch)

select {

case r := <-ch:

return r

case <-time.After(21 * time.Millisecond):

}

}

return <-ch

}

结论

仅用几行代码,我们就可以大幅改善尾部延迟。在将其用作生产系统之前,该示例还有很多需要改进的地方,但核心实现与此没有太大区别。 该技术针对一个非常具体的问题,在用于实际生产应用之前应进行彻底分析。

原文链接:https://kerkour.com/why-not-rust

翻译:trdthg

选题:子殊

什么时候不应该使用 Rust?

我非常相信 Rust 是提高软件性能和可靠性的一大步,这不仅能进一步加速软件开发,还能赚更多的 $$! Rust 的 Immutable 和较好的抽象能力能够极大的便利开发者。

但是任何事物总有两面性,Rust 不可能总是最优选择。我将在下面讨论一些不适合使用 Rust 的场景。

原型设计 & 黑客松

Rust 语言本身更倾向于可靠性而不是开发速度。因此,如果你只有 1~2 天的时间进行开发,你应该把宝贵的时间用在更有用的地方,而不是花在手动管理内存,处理每一个边缘情况上。

相反,如果你的项目要开发几周,Rust 的可靠性能帮你减轻后期的监控和调试的压力,省下大把的时间和金钱。

独立开发者

Rust 的第三方库生态尚且年轻。如果你是一个独立开发者,你可能像要外包尽可能多的工作,因此 Rust 可能不是最适合的。你可能更喜欢使用生态完善的语言,他们有大量开箱即用的第三方库。

另一方面,Rust 的可靠性其实也降低了独立开发者对监控和调试的需求。

与 SaaS 服务集成

如果你的应用需要与第三方 API 进行交互,你应该使用那些有官方 SDK 支持的语言,比如 TypeSript 或者 Python。

话虽这么说,现在 AWS 也有了许多官方的 Rust SDK,我希望更多的公司能够学习并提供 Rust SDK。

只是想完成而不是做到完美

老实说,并非所有软件都需要 Rust 提供的可靠性和性能。有时候,一些 bug 是可以接受的,Rust 只会让你慢下来。在这些场景下,您应该会更喜欢像 Go 等更无聊的语言。

原文链接:https://thenewstack.io/using-rustlangs-async-tokio-runtime-for-cpu-bound-tasks/

翻译:trdthg

选题:Akagi201

使用 Tokio 处理 CPU 密集型任务

尽管 async 通常都被应用于异步网络 I/O,但是在这篇文章里,我会像你介绍为什么使用 Tokio 处理 CPU 密集型任务(比如数据分析引擎等)也是一个不错的选择。

Tokio 是什么?

Rust 本身提供了一个类似于 JavaScript 的异步编程模型。

为了充分利用多核和异步 I/O。一个运行时是必须的,尽管社区有很多异步运行时的选择,但是 Tokio 是事实上的标准。尽管 Tokio 在官网上描述到它是 Rust 语言的一个异步运行时,并且提供了编写网络服务所需要的模块,它也可以被用在其它场景。

为什么使用 Tokio 处理 CPU 密集型任务

现代化的数据分析引擎总是不可避免的要处理来自客户端的网络请求,以及通过网络和对象存储系统(比如 ASW S3、GCP Cloud、Azure 等)进行通信。因此,任何使用 Rust 实现的系统,大多都会用 Tokio 去处理这部分网络相关的服务,或者是一部分文件 I/O 服务。

除了应对网络外,数据分析引擎还需要做大量繁重的的 CPU 计算,消耗大量 CPU 资源去进行诸如:重新组织数据存储、提前计算各种索引、或者是直接回复客户端请求等工作。这些复杂计算通常会被切成许多单独的块(我把它们称为 "任务"),然后被并行的处理,以利用到现代 CPU 的多核特性。

任务调度器会决定哪个任务应该在什么时候运行,它会将任务映射到合适的 CPU 内核或者是线程上。

学术界和工业界对于各种任务调度器、工作池、线程池等已经积累了很多年的研究。

我自己已经实现并且使用过几个自定义的任务调度器。他们在大多数时间 (99.9%) 都工作的很好,但是在处理边缘情况(比如快速停机、任务取消、清理等)时,他们的效果非常不尽人意。由于这些任务调度器使用了较低级别的线程原语,出现线程间竞争的情况比比皆是,所以我不建议这样做。

因此,当我在 Rust 生态中寻找一个任务调度器时,你会很自然的选择 Tokio。Tokio 有很多优势:

- 你只需要 Tokio,并不需要添加其他依赖项。

- Tokio 实现了一个复杂的 支持任务窃取的调度器。

- Tokio 内部实现了对 async/await 的支持。并且有许多相对成熟的库去处理流、异步锁、管道、异步取消等。

- Tokio 在 Rust 生态系统中经过了良好测试,并且有着大量使用案例。

- Tokio 通常会将正在运行的任务和

Future放在同一个执行器内,这有利于实现局部缓存。 - Tokio 的 文档 很完善,并且在积极更新维护。

因此,选择 Tokio 作为 CPU 密集型任务的任务调度程序是理所应当的,对吧?WROOOOOOOONG!

使用 Tokio 的反对意见

选择 Tokio 在我们团队中变成了一个热门话题,到现在依然不是所有人都认可这个决定。在我们做 DataFusion 和 InfluxDB IOx 的早期,我们很担心这个问题。以下是一些反对意见:

Tokio 文档的警告:

老版本的 Tokio 文档(比如 1.10 版)里面有一条著名的警告:

If your code is CPU-bound and you wish to limit the number of threads used to run it, you should run it on another thread pool such as Rayon.

如果你的代码要处理 CPU 密集型任务,并且想要尽量减少使用到的线程数,你应该将这些任务分配到另一个线程池比如 Rayon。

这个警告对我们团队和社区都造成了很大的困惑。很多人读了之后都以为 Tokio 永远不应该用来处理 CPU 密集型任务。但是文档的关键其实是说,一个运行时实例(同一个线程池)不应该同时用于 I/O 和 CPU 计算,我们之后澄清了文档 的意图。

顺便说一句,Tokio 文档建议用 Rayon 处理 CPU 密集型任务。Rayon 对于很多程序都是很好的解决方案,但是它并不支持异步。如果你的代码中哪怕只有一点需要使用异步,那你就不得不跨过同步和异步的痛苦边界。我还发现实现一个 基于拉取的执行器模型 会更困难,这种模型要求某个任务必须等待所有的输入都准备好在能在 Rayon 中运行

尾部延迟会拖累你

聪明的人会说:使用 Tokio 处理 CPU 密集型任务会增加请求的尾部延迟,这是难以令人接受的。

尾部延迟?🙄

你可能认为:我正在编写一个数据库,尾部延迟听起来像是对于高负载的 Web 服务器的一个学术问题……”

但其实,这也是需要考虑的:思考一下健康检查,健康检查对于使用容器编排系统(比如 Kubernetes)部署的服务是必不可少的。检查的方式通常是发送一个 HTTP

请求到某个 API ,例如 /health。如果该请求已经被分派到某一个任务队列中,但是 Tokio 正在忙于使用 CPU 进行大量数据处理任务,那么

Kubernetes 将不能及时得到 “系统正常” 的响应,你的进程就会被 K8s 杀死。因此得到结论:由于尾部延迟,你不能将 Tokio 用于 CPU

密集型任务。

但是,就像 Tokio 在文档中阐述的,想要防止你的程序在 CPU 完全饱和的情况下被 K8s

误杀,你应该使用两个独立的线程池。一个用来执行对尾部延迟敏感的任务,就比如响应 /health 接口。另一个用来执行 CPU

密集型任务。这些线程池的的最佳线程数需要根据具体需求去调整。

如果你将 Tokio 运行时只是视为一个复杂点的线程池,那么使用多个运行时实例的想法可能更容易接受,我们将在最后使用专用的执行器演示如何实现这个想法。

单任务开销很高

Tokio 的每个任务开销很高。

对于这点,我一点也不惊讶。人们总是可以实现比 Tokio 运行速度更快的线程池。但是,这些线程池并不是足够稳定,难以应对生产环境的负载,并且他们也不具备像 Tokio 一样的庞大生态系统。

在许多场景下,单任务的开销可以使用 “矢量化处理” 来分摊。意思是每个任务回同时处理几千行数据而不是单单一行,你需要将任务分成合理大小的块。你也不能分摊所有工作场景下的开销。但是,对于我们的程序关心的实例来说,Tokio 的任务开销已经微乎其微了

实践

假设你已经被说服了使用 Tokio 去处理 CPU 密集型任务是可行的。现在你应该怎么做?

首先,至关重要的一点是,你的代码应该符合以下原则:异步代码永远不应该花费很长时间才能完成,这一点请参考 Alice Ryhl 的 Async: What is blocking?。这是为了让调度器有机会安排其他事情,比如任务窃取等。

当然了,这个 “很长时间” 取决于你的程序;Ryhl 建议在优化响应的尾部延迟时,单个异步任务完成时间应该在 10 ~ 100 微秒。我认为在针对 CPU 进行优化时 10~100 毫秒也能有不错的效果。但是在我的测试 estimated per-task Tokio overhead 中,Tokio 单任务的开销在约 10 纳秒范围内,因此几乎不可能用 10 毫秒的任务来测量 Tokio 运行时开销。

其次,将任务分派到一个单独的执行器

专用的执行器

这里是一个简单的例子,演示了我们如何在 InfluxDB IOx 上将任务分配到一个单独的 Tokio 运行时上(完整代码可以在我们的仓库里查看,里面还有关于清理、停机、合并的内容)

pub struct DedicatedExecutor {

state: Arc<Mutex<State>>,

}

/// Runs futures (and any `tasks` that are `tokio::task::spawned` by

/// them) on a separate Tokio Executor

struct State {

/// Channel for requests -- the dedicated executor takes requests

/// from here and runs them.

requests: Option<std::sync::mpsc::Sender<Task>>,

/// Thread which has a different Tokio runtime

/// installed and spawns tasks there

thread: Option<std::thread::JoinHandle<()>>,

}

impl DedicatedExecutor {

/// Creates a new `DedicatedExecutor` with a dedicated Tokio

/// executor that is separate from the threadpool created via

/// `[tokio::main]`.

pub fn new(thread_name: &str, num_threads: usize) -> Self {

let thread_name = thread_name.to_string();

let (tx, rx) = std::sync::mpsc::channel::<Task>();

let thread = std::thread::spawn(move || {

// Create a new Runtime to run tasks

let runtime = Tokio::runtime::Builder::new_multi_thread()

.enable_all()

.thread_name(&thread_name)

.worker_threads(num_threads)

// Lower OS priority of worker threads to prioritize main runtime

.on_thread_start(move || set_current_thread_priority_low())

.build()

.expect("Creating Tokio runtime");

// Pull task requests off the channel and send them to the executor

runtime.block_on(async move {

while let Ok(task) = rx.recv() {

Tokio::task::spawn(async move {

task.run().await;

});

}

let state = State {

requests: Some(tx),

thread: Some(thread),

};

Self {

state: Arc::new(Mutex::new(state)),

}

}

这段代码会在一个新线程 std::thread,并在这个线程里创建了一个新的 Tokio 运行时。运行时会从 channel 获取任务并运行。

注意:这个新的线程很关键,如果你尝试在主线程里或者是任何已经创建过 Tokio 运行时的线程里再次创建新的运行时,程序就会报错,因为已经有一个运行时了。

下面的代码将任务分派到第二个运行时。

impl DedicatedExecutor {

/// Runs the specified Future (and any tasks it spawns) on the

/// `DedicatedExecutor`.

pub fn spawn<T>(&self, task: T) -> Job<T::Output>

where

T: Future + Send + 'static,

T::Output: Send + 'static,

{

let (tx, rx) = tokio::sync::oneshot::channel();

let fut = Box::pin(async move {

let task_output = task.await;

tx.send(task_output).ok()

});

let mut state = self.state.lock();

let task = Task {

fut,

};

if let Some(requests) = &mut state.requests {

// would fail if someone has started shutdown

requests.send(task).ok();

} else {

warn!("tried to schedule task on an executor that was shutdown");

}

Job { rx, cancel }

}

}

上面的代码使用了一个名为 Job 的结构体,它是一个对 Future 的简单包装,Job 能够将 Future 的执行结果从单独的执行器内传输回主线程。相关代码如下。

#[pin_project(PinnedDrop)]

pub struct Job<T> {

#[pin]

rx: Receiver<T>,

}

impl<T> Future for Job<T> {

type Output = Result<T, Error>;

fn poll(

self: Pin<&mut Self>,

cx: &mut std::task::Context<'_>,

) -> std::task::Poll<Self::Output> {

let this = self.project();

this.rx.poll(cx)

}

}

就是这样! 你可以在 Github gist 中找到所有代码。

原文链接:https://lucumr.pocoo.org/2022/1/30/unsafe-rust/

翻译:trdthg

选题:trdthg

未初始化内存:unsafe Rust 太难了

Rust 在很多意义上不仅仅是一个现代的系统编程语言,也是一个实用的语言。它承诺了自己的安全性,并且提供了一个完整的框架,使得创建安全的抽象成为可能,同时运行时开销很小甚至为 0。你可以使用 unsafe 来明确的脱离安全的 Rust。

如果你之前看过这篇文章,你会惊讶的发现,它和之前的版本大不相同。这篇文章的作者是被 unsafe 的规则所困惑的受害者。我在文章中增加了一个例子,用来更好的展示其中的陷阱。我之前在 Twitter 上说过,编写 unsafe Rust 比 C / C++ 更困难,所以我想为我的观点作出一些解释。

从 C 到 Rust

我们从下面的例子开始:我们有一个待初始化的结构体。比较有趣的字段是

name。它是一个指针,指向一个已经分配好的字符串。除此之外,分配到哪里对我们并不重要,因此我们可以将这个结构体自身分配在栈上。我们的想法是,当这个结构体被初始化之后,它就可以被安全的传递和打印。

#include <stdio.h>

#include <stdlib.h>

#include <stdbool.h>

struct role {

char *name;

bool disabled;

int flag;

};

int main() {

struct role r;

r.name = strdup("basic");

r.flag = 1;

r.disabled = false;

printf("%s (%d, %s)\n", r.name, r.flag, r.disabled ? "true" : "false");

free(r.name);

}

接下来我们用 Rust 去实现上面的代码。现在我们并不需要过多的关注 Rust 文档,只需要专注于一对一翻译即可。在你阅读下面的代码之前还有一点要注意:我们正在有意的创建一个对 Rust 程序员更熟悉的对象,并且可以被看作公共 API。所以我们在这里直接使用 String,而不是 C 语言的字符串。

use std::mem;

struct Role {

name: String,

disabled: bool,

flag: u32,

}

fn main() {

let role = unsafe {

let mut role: Role = mem::zeroed();

role.name = "basic".to_string();

role.flag = 1;

role.disabled = false;

role

};

println!("{} ({}, {})", role.name, role.flag, role.disabled);

}

看到这里,立即就有人想问,这里为什么需要

unsafe?当然了,你的确不需要。但是这段代码使用了一个函数:std::mem::zeroed。如果你尝试在最近的 Rust

编译器运行,应该会的得到这个错误:

thread 'main' panicked at 'attempted to zero-initialize type `Role`,

which is invalid', src/main.rs:11:30

老版本的编译器能够正常运行,但是那其实也是错误的。怎么解决呢?编译器又一次告诉我们解决之法:

warning: the type `Role` does not permit zero-initialization

--> src/main.rs:11:30

|

11 | let mut role: Role = mem::zeroed();

| ^^^^^^^^^^^^^

| |

| this code causes undefined behavior when executed

| help: use `MaybeUninit<T>` instead, and only call

| `assume_init` after initialization is done

|

为什么 Role 类型不支持使用 0 初始化呢?我们需要改动那些代码?我们能不能不初始化?

有人可能会想,使用 #[repr(C)] 强制结构体使用 C 语言的内存布局,但是这不能解决问题。正如编译器给出的建议,我们需要

MaybeUninit。

use std::mem::MaybeUninit;

struct Role {

name: String,

disabled: bool,

flag: u32,

}

fn main() {

let role = unsafe {

let mut uninit = MaybeUninit::<Role>::zeroed();

let role = uninit.as_mut_ptr();

(*role).name = "basic".to_string();

(*role).flag = 1;

(*role).disabled = false;

uninit.assume_init()

};

println!("{} ({}, {})", role.name, role.flag, role.disabled);

}

将 zeroed 换为 MaybeUninit::zeroed 之后,一切都变了。现在我们不能直接使用结构体,而是要操作一个裸指针。由于裸指针没有实现

deref,并且 Rust 中没有 -> 操作符,我们需要手动解引用,并用这种笨拙的语法分配每一个字段。

首先:这样做可行吗?答案是肯定的。但是它正确吗?不正确。

答案在于,任何像可变引用(&mut)或者是栈上的值本身这样的构造,在 unsafe 代码之外仍然需要一直处于有效的状态。zeroed 返回一个值为 0

的结构,我们不能保证它可以有效的表示结构体或者任何其中的字段。在我们的例子中,我们的字符串在所有内容被清零的情况下是有效的,但是这并不能保证,而且是未定义行为。

需要注意的一点是,一个可变引用永远不能指向一个无效的对象,所以在对象的所有字段都被初始化之前,下面的操作是错误的:

let role = &mut *uninit.as_mut_ptr()

所以,让我们把 zeroed 改为 uninit。如果我们再次运行,程序就会崩溃。

// let mut uninit = MaybeUninit::<Role>::uninit();

free(): invalid pointer

为什么会崩溃呢?答案是,通过给 name 赋值一个新的字符串,我们也 drop 了之前的旧字符串。我们之前只是碰巧没有遇到这种情况,因为 Drop 碰巧能够处理一个被清零的字符串。但现在,我们深入了未定义行为。我们如何解决这个问题呢?我们需要以某种方式直接将字符串写到那里的指针。

我们首先要接受 MaybeUninit 是必要的,现在我们要处理这里的裸指针。这有些麻烦,但是看起来不是特别难。现在我们有两个新问题:我们知道 &mut X

是不允许的,但是 *mut X 是允许的。我们如何在不使用 &mut X 的情况下得到一个 *mut X? 讽刺的是,在 Rust 1.51

之前,再不打破任何规则之前,这是不可能的,但是现在,你可以使用 addr_of_mut! 宏。

let name_ptr = std::ptr::addr_of_mut!((*role).name);

太棒了,现在我们拿到了 name 的指针,如何写入呢?我们可以使用 write 方法。

addr_of_mut!((*role).name).write("basic".to_string());

现在完成了吗?还记得我们是如何使用普通结构体的吗?如果阅读一下文档,你就会发现,结构体的内存布局没有任何保证。事实表明,尽管目前的文档是这样说的,但是我们可以依靠字段的对齐性。如果我们处理的是

#[repr(packed)],我们就必须使用 write_unaligned 方法来代替。如果 Rust

选择的结构体的一个成员是不对齐的,这是合法的。

最终的代码:

use std::mem::MaybeUninit;

use std::ptr::addr_of_mut;

struct Role {

name: String,

disabled: bool,

flag: u32,

}

fn main() {

let role = unsafe {

let mut uninit = MaybeUninit::<Role>::uninit();

let role = uninit.as_mut_ptr();

addr_of_mut!((*role).name).write("basic".to_string());

(*role).flag = 1;

(*role).disabled = false;

uninit.assume_init()

};

println!("{} ({}, {})", role.name, role.flag, role.disabled);

}

什么时候用 addr_of_mut!

一般有两种情况:未初始化的内存,未对齐的引用。Rust 不允许用户创建一个未对齐的引用(即时只是暂时的),同时也不允许创建一个对未初始化内存的引用。那么,这些引用是什么时候被创建的呢?

对于下面的代码:(*flag).flag = 1,根据 Rust 的规则,如果一个类型没有实现 Drop,这是可以的。如果该类型实现了

Drop,这行代码会产生很多问题:当 Drop::drop 被调用时,并且调用在未初始化的内存上,这时我们就需要

addr_of_mut!。这就是为什么我们可以直接为 flag 字段赋值,但是我们却需要通过 addr_of_mut! 来获取 name

字段,因为它是一个字符串。

MaybeUninit

对安全的理解随着时间的推移而不断改变。曾经,mem::uninitialized 被认为是一个健全的 API,但是在后来,MaybeUninit

被引入去解决发现的缺点。但是,由于部分初始化的类型的存在,MaybeUninit 在实践中并不理想。虽然由于 #[repr(transparent)],

MaybeUninit 和 T 是内存兼容的,但是在嵌套使用时的效果并不佳。

有时你需要结构体的某个字段上有一个 MaybeUninit,但是只后你又希望这个抽象不存在,这种情况并不罕见。实际上,在实践中使用 MaybeUninit 是一个充满挑战的体验,但是这篇文章并没有体现出来。

我的 unsafe 代码正确吗?

在 2022 年,我承认,我不再对编写 Rust 代码感到自信。unsafe 的规则可能可能都是如此复杂,但是从我多年来阅读过的 unsafe 代码来说,大多数

unsafe 代码都不太关心这些规则,并且无视了它们。addr_of_mut!直到 1.53 才被添加到语言中是有原因的。即使到了今天,文档中都说它

Rust 结构体 repr 的对齐方式没有任何保证。

在过去的几年里,似乎发生了这样的事情:Rust 开发者在实践中编写 unsafe

越来越困难,现在的规则是如此复杂,以至于对一个随意的程序员来说非常难以理解,围绕他的文档也很容易被曲解。我在这篇文章的上一个版本中认为

addr_of_mut! 的一些使用是必要的,但实际上并非如此。在有人指出这个错误之前,文章已经得到了大量关注。

这些规则使得 Rust 最好的功能之一越来越难以接近,同时也越来越难以理解。要求存在 MaybeUninit,而不仅仅是过去的 mem::uninitialized API 是显而易见的,但是却展示了语言规则是多么的复杂。

我不认为这是好的。事实上,我认为这根本不是一个好的趋势,好像越来越少的人了解 unsafe Rust。与 C 的互操作性是让 Rust 伟大的一个原因,但是我们现在正在创建巨大的屏障,这是不可取的。更重要的是:编译器在指出我的错误时没有什么帮助。

让 unsafe 变得更符合人体工程学是一个困难的问题,但是它值得被解决。因为有一点很明确:人们不会很快停止编写 unsafe 代码。

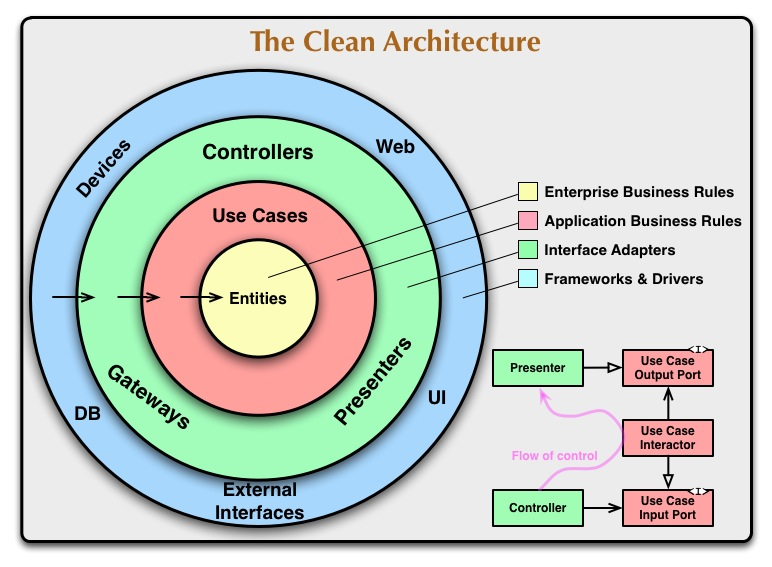

Rust 六边形架构

六边形架构基本介绍

六边形架构,是一种软件设计模式。依照这种架构创建的程序,能够在没有 UI 或数据库的情况下正常工作。所以即使没有数据库你依然可以进行开发和运行自动化测试,而且无需其他用户参与。

端口与适配器

六边形架构也叫做端口与适配器架构。

什么是端口?

端口指的是六边形的边,属于应用程序的内部,是我们应用程序的入口和出口。它定义了一个接口,表示设备如何使用我们的用例。在 Rust 里就是由一个 Trait,以及一些 DTO 组成

什么是适配器?

适配器围绕着端口编写,能够将输入转化为符合端口的类型,并把输入转化为用用程序内部的方法调用。换句话说就是 controller 或者是命令行一条命令处理器。

当任何外部设备 (比如:WEB,APP,终端,测试...) 想要访问输入端口时,首先这个输入会被该设备对应的输入适配器,转化为符合要求的可用的方法调用,或者是消息,然后再传递给我们的应用程序。

当我们的应用程序需要向外发送数据时,首先它会把数据通过输出端口传递给输出适配器,然后再传递给输出对象 (比如:数据库,mock,API,邮件,消息队列...)

因此我们的应用程序外部是完全隔离的。

应用程序核心

使用六边形架构之后,我们应用程序的核心部分通常被称作域,域中有三个核概念:

- 实体 (Entities):只是简单的定义了对象。

- 交互器 (Interactors):实现复杂的业务逻辑,在本文里我们会将其称为用例 Usecase。

- 存储库 (Repositories):只定义了操作实体的方法。

优点

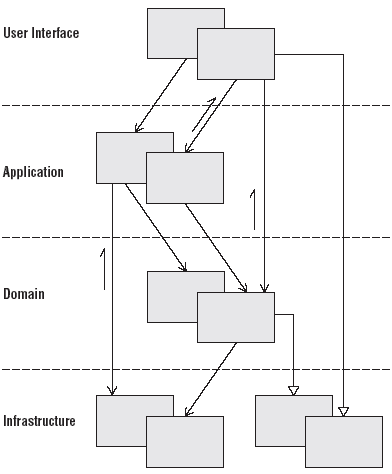

在传统的分层架构中,只能从上往下调用。

而现在我们把接口保留在域中,域不再依赖外部的外部实现。保证了外部设备是可替换的。当业务逻辑需要用到数据存储时,直接调用抽象接口即可。

将要做些什么?

在接下来的文章里,我们将会实现一个 pokemon 服务。主要功能是增加、删除和查询。

为了体现六边形架构的优点,我们将会实现两套用户接口,包括 HTTP API 和 CLI。三套存储库,包括内存,SQLite 数据库和 Airtable (一个在线表格应用)。

六边形架构的核心不需要依赖于具体的存储库或者是用户接口,为了我们的程序能够稳定运行,我们也会非常注重于单元测试。一旦我们的域稳定下来,实现用户接口,替换存储库都会是非常简单快速的。

项目结构

src/

├── api

│ ├── fetch_pokemon.rs

│ └── mod.rs

├── cli

│ ├── fetch_pokemon.rs

│ └── mod.rs

├── domain

│ ├── entities.rs

│ ├── fetch_pokemon.rs

│ └── mod.rs

├── main.rs

└── repositories

├── mod.rs

└── pokemon.rs

六边形架构的核心部分通常被称作域,就是下面的 domain 模块,里面包括实体的定义和用例的实现。api 和 cli

是两套用户接口。repositories 中则是存储库的定义与实现

延申阅读

- 六边形架构 ( hexagonal-architecture )

- 干净架构 ( the-clean-architecture )

- 洋葱架构 ( The Onion Architecture )

- 软件架构编年史 ( The Software Architecture Chronicles )

原文链接:https://alexis-lozano.com/hexagonal-architecture-in-rust-4/

翻译:trdthg

选题:trdthg

2021-09-02 - Rust 六边形架构 #4 - 重构

这篇文章是下面系列的一部分

- Hexagonal architecture in Rust #1 - Domain

- Hexagonal architecture in Rust #2 - In-memory repository

- Hexagonal architecture in Rust #3 - HTTP API

- Hexagonal architecture in Rust #4 - Refactoring

- Hexagonal architecture in Rust #5 - Remaining use-cases

- Hexagonal architecture in Rust #6 - CLI

- Hexagonal architecture in Rust #7 - Long-lived repositories

嗨,又是我!起初,我想实现我们仍然需要处理的剩余的用例。但这将会是下一次的内容。今天我们将做一些重构 :)

开始之前

我做了两个我在第一篇文章中没有看到的更改。在 domain/entities.rs 中,我用 Self 替换了 u16:

impl From<PokemonNumber> for u16 {

fn from(n: PokemonNumber) -> Self {

n.0

}

}

在 repositories/pokemons.rs 中,我在 with_error 上添加了一个测试注释:

impl InMemoryRepository {

#[cfg(test)]

pub fn with_error(self) -> Self {

Self {

error: true,

..self

}

}

}

让我们现在进行重构 :)

使用 Result 替换自定义枚举

之前我们使用自定义枚举作为用例和 存储库 的返回值,现在把他们重构为 Result。

更改用例的返回值类型

首先,我们将用例的返回值暂时设置为 500 以方便测试、

pub fn serve(repo: Arc<dyn Repository>, req: &rouille::Request) -> rouille::Response {

let req = ...

rouille::Response::from(Status::InternalServerError)

// match create_pokemon::execute(repo, req) {

// create_pokemon::Response::Ok(number) => rouille::Response::json(&Response { number }),

// create_pokemon::Response::BadRequest => rouille::Response::from(Status::BadRequest),

// create_pokemon::Response::Conflict => rouille::Response::from(Status::Conflict),

// create_pokemon::Response::Error => rouille::Response::from(Status::InternalServerError),

// }

}

现在我们将测试的返回值修改为 Result 类型:

#[test]

fn it_should_return_a_bad_request_error_when_request_is_invalid() {

...

match res {

Err(Error::BadRequest) => {}

_ => unreachable!(),

};

}

#[test]

fn it_should_return_a_conflict_error_when_pokemon_number_already_exists() {

...

match res {

Err(Error::Conflict) => {}

_ => unreachable!(),

}

}

#[test]

fn it_should_return_an_unknown_error_when_an_unexpected_error_happens() {

...

match res {

Err(Error::Unknown) => {}

_ => unreachable!(),

};

}

#[test]

fn it_should_return_the_pokemon_number_otherwise() {

...

match res {

Ok(res_number) => assert_eq!(res_number, number),

_ => unreachable!(),

};

}

}

接着再修改用例,把它的返回值修改为 Result:

pub fn execute(repo: Arc<dyn Repository>, req: Request) -> Result<u16, Error> {

...

(Ok(number), Ok(name), Ok(types)) => match repo.insert(number, name, types) {

Insert::Ok(number) => Ok(u16::from(number)),

Insert::Conflict => Err(Error::Conflict),

Insert::Error => Err(Error::Unknown),

},

_ => Err(Error::BadRequest),

}

}

测试现在应该通过了!

cargo test

running 4 tests

test it_should_return_a_conflict_error_when_pokemon_number_already_exists ... ok

test it_should_return_a_bad_request_error_when_request_is_invalid ... ok

test it_should_return_an_unknown_error_when_an_unexpected_error_happens ... ok

test it_should_return_the_pokemon_number_otherwise ... ok

最后再去修改我们的 API:

pub fn serve(repo: Arc<dyn Repository>, req: &rouille::Request) -> rouille::Response {

let req = ...

match create_pokemon::execute(repo, req) {

Ok(number) => rouille::Response::json(&Response { number }),

Err(create_pokemon::Error::BadRequest) => rouille::Response::from(Status::BadRequest),

Err(create_pokemon::Error::Conflict) => rouille::Response::from(Status::Conflict),

Err(create_pokemon::Error::Unknown) => rouille::Response::from(Status::InternalServerError),

}

}

Usecase 修改完成,接下来我们去处理 Reposity

更改 Repository 的返回类型

Repository 没有测试,所以我们从修改用例调用 repo 的返回值开始:

use crate::repositories::pokemon::{InsertError, ...};

...

pub fn execute(repo: Arc<dyn Repository>, req: Request) -> Result<u16, Error> {

...

(Ok(number), Ok(name), Ok(types)) => match repo.insert(number, name, types) {

Ok(number) => Ok(u16::from(number)),

Err(InsertError::Conflict) => Err(Error::Conflict),

Err(InsertError::Unknown) => Err(Error::Unknown),

},

_ => Err(Error::BadRequest),

}

}

在宝可梦编号冲突的测试时,您应该将 .ok() 添加到存储库 insert 操作之后。现在让我们在 repositories/pokemon.rs

中删除 Insert 并创建 InsertError:

pub enum InsertError {

Conflict,

Unknown,

}

最后在更改 Repository Trait 和 InMemoryRepository 的返回值类型即可:

pub trait Repository: Send + Sync {

fn insert(&self,

number: PokemonNumber,

name: PokemonName,

types: PokemonTypes,

) -> Result<PokemonNumber, InsertError>;

}

impl Repository for InMemoryRepository {

fn insert(

&self,

number: PokemonNumber,

name: PokemonName,

types: PokemonTypes,

) -> Result<PokemonNumber, InsertError> {

if self.error {

return Err(InsertError::Unknown);

}

let mut lock = match self.pokemons.lock() {

Ok(lock) => lock,

_ => return Err(InsertError::Unknown),

};

if lock.iter().any(|pokemon| pokemon.number == number) {

return Err(InsertError::Conflict);

}

let number_clone = number.clone();

lock.push(Pokemon::new(number_clone, name, types));

Ok(number)

}

}

填加一个新的用例

在常规的 HTTP API 中,每次创建一个新的对象,我通常会把这个对象在返回回去。特别是当返回的对象中包含一切前端没有传来的字段。比如 create_at

等由存储库添加的字段。

首先,我需要你像我们一开始那样暂时注释掉 api/create_pokemon.rs。以便于我们专注于测试。

在 domain/create_pokemon.rs 中添加一个新的测试:

#[test]

fn it_should_return_the_pokemon_number_otherwise() {

let repo = Arc::new(InMemoryRepository::new());

let req = Request {

number: 25,

name: String::from("Pikachu"),

types: vec![String::from("Electric")],

};

let res = execute(repo, req);

match res {

Ok(Response {

number,

name,

types,

}) => {

assert_eq!(number, 25);

assert_eq!(name, String::from("Pikachu"));

assert_eq!(types, vec![String::from("Electric")]);

}

_ => unreachable!(),

};

}

同时创建一个 Response 结构体

pub struct Response {

pub number: u16,

pub name: String,

pub types: Vec<String>,

}

接下来,我们将修改 execute 函数,在插入成功时应该返回 Pokemon 的所有字段:

use crate::domain::entities::{Pokemon, ...};

pub fn execute(repo: Arc<dyn Repository>, req: Request) -> Result<Response, Error> {

...

(Ok(number), Ok(name), Ok(types)) => match repo.insert(number, name, types) {

Ok(Pokemon {

number,

name,

types,

}) => Ok(Response {

number: u16::from(number),

name: String::from(name),

types: Vec::<String>::from(types),

}),

Err(InsertError::Conflict) => Err(Error::Conflict),

Err(InsertError::Unknown) => Err(Error::Unknown),

},

_ => Err(Error::BadRequest),

}

}

在 insert 执行成功后,直接返回一个 Pokemon 结构体:

pub trait Repository: Send + Sync {

fn insert(

&self,

number: PokemonNumber,

name: PokemonName,

types: PokemonTypes,

) -> Result<Pokemon, InsertError>;

}

impl Repository for InMemoryRepository {

fn insert(

&self,

number: PokemonNumber,

name: PokemonName,

types: PokemonTypes,

) -> Result<Pokemon, InsertError> {

...

let pokemon = Pokemon::new(number, name, types);

lock.push(pokemon.clone());

Ok(pokemon)

}

}

为了使 pokemon.clone() 能够正常工作,我们需要为 Pokemon 实现 Clone Trait:

#[derive(Clone)]

pub struct PokemonName(String);

#[derive(Clone)]

pub struct PokemonTypes(Vec<PokemonType>);

#[derive(Clone)]

enum PokemonType {

#[derive(Clone)]

pub struct Pokemon {

现在存储库的插入逻辑已经完成,用例希望能够直接拿到 Pokemon 的 name 和 types 字段,我们需要把这两个字端也转为公开的:

pub struct Pokemon {

pub number: PokemonNumber,

pub name: PokemonName,

pub types: PokemonTypes,

}

接着,我们需要为 Response 实现类型转换,从 PokemonNumber 转换为 u16、从 PokemonName 转换为

String、从 PokemonTypes 转换为 Vec<String>:

impl From<PokemonName> for String {

fn from(n: PokemonName) -> Self {

n.0

}

}

impl From<PokemonTypes> for Vec<String> {

fn from(pts: PokemonTypes) -> Self {

let mut ts = vec![];

for pt in pts.0.into_iter() {

ts.push(String::from(pt));

}

ts

}

}

impl From<PokemonType> for String {

fn from(t: PokemonType) -> Self {

String::from(match t {

PokemonType::Electric => "Electric",

PokemonType::Fire => "Fire",

})

}

}

现在测试应该能够通过了:

cargo test

running 4 tests

test it_should_return_a_conflict_error_when_pokemon_number_already_exists ... ok

test it_should_return_a_bad_request_error_when_request_is_invalid ... ok

test it_should_return_an_unknown_error_when_an_unexpected_error_happens ... ok

test it_should_return_the_pokemon_number_otherwise ... ok

最后,我们去更新 api 的内容:

#[derive(Serialize)]

struct Response {

number: u16,

name: String,

types: Vec<String>,

}

pub fn serve(repo: Arc<dyn Repository>, req: &rouille::Request) -> rouille::Response {

let req = ...

match create_pokemon::execute(repo, req) {

Ok(create_pokemon::Response {

number,

name,

types,

}) => rouille::Response::json(&Response {

number,

name,

types,

}),